ความเอนเอียงเพื่อยืนยัน

ความเอนเอียงเพื่อยืนยัน (ความคิดฝ่ายตน)[1] หรือ ความลำเอียงเพื่อยืนยัน (อังกฤษ: Confirmation bias, confirmatory bias, myside bias) เป็นความลำเอียงในข้อมูลที่ยืนยันความคิดหรือทฤษฎีหรือสมมติฐานฝ่ายตน[A][2] เรียกว่ามีความลำเอียงนี้เมื่อสะสมหรือกำหนดจดจำข้อมูลที่เลือกเฟ้น หรือว่าเมื่อมีการตีความหมายข้อมูลอย่างลำเอียง

ความลำเอียงนี้มีอยู่ในระดับสูงในประเด็นที่ให้เกิดอารมณ์หรือเกี่ยวกับความเชื่อที่ฝังมั่น นอกจากนั้นแล้ว คนมักตีความหมายข้อมูลที่ยังไม่ชัดเจนว่าสนับสนุนความคิดเห็นของตนเอง มีการใช้การสืบหา การตีความหมาย และการทรงจำข้อมูลประกอบด้วยความลำเอียงเช่นนี้ เพื่ออธิบายปรากฏการณ์ต่าง ๆ รวมทั้ง

- ความเห็นที่สุดโต่งเพิ่มขึ้น (attitude polarization) คือเมื่อข้อขัดแย้งรุนแรงยิ่งขึ้นแม้ว่าทุก ๆ ฝ่ายจะได้หลักฐานเดียวกัน

- ความยึดมั่นอยู่กับความเชื่อ (belief perseverance) แม้ว่าหลักฐานจะแสดงว่าเป็นความเชื่อผิด ๆ

- การให้น้ำหนักกับหลักฐานที่ได้ตอนต้น ๆ ที่ไร้เหตุผล (irrational primacy effect) เป็นการให้น้ำหนักกับหลักฐานที่ได้ในตอนต้นและตอนอื่น ๆ ที่ไม่เท่ากัน

- สหสัมพันธ์ลวง (illusory correlation) คือมีการเชื่อมเหตุการณ์หรือสถานการณ์สองอย่างเข้าด้วยกัน โดยสร้างความสัมพันธ์ที่ไม่เป็นจริง

งานทดลองหลายงานในช่วงคริสต์ทศวรรษ 1960 ส่อว่า มนุษย์มีความลำเอียงที่จะยืนยันความเชื่อที่มีอยู่ของตน ส่วนงานวิจัยต่อ ๆ มาตีความหมายของผลการทดลองเหล่านั้นใหม่ว่า เป็นความเอนเอียงที่จะทดสอบความคิดต่าง ๆ จากทางด้านเดียวเท่านั้น คือ ให้ความสนใจต่อข้อสันนิษฐานเพียงข้อเดียวโดยที่ไม่ใส่ใจข้อสันนิษฐานที่เป็นไปได้ข้ออื่น ๆ ในบางกรณี ความลำเอียงนี้สามารถทำลายความเป็นกลางของข้อสรุป เหตุที่ใช้ในการอธิบายความลำเอียงเช่นนี้รวมทั้งความอยากที่จะให้เป็นอย่างนั้น (wishful thinking) และสมรรถภาพที่จำกัดในการประมวลข้อมูลของมนุษย์ ส่วนคำอธิบายอีกอย่างหนึ่งก็คือมนุษย์มีความเอนเอียงเพื่อยืนยันความคิดฝ่ายตน เพราะคำนึงถึงประโยชน์ที่จะเสียไปถ้าตนเองเป็นฝ่ายผิด แทนที่จะตรวจสอบข้อเท็จจริงโดยเป็นกลาง ๆ โดยใช้วิธีการทางวิทยาศาสตร์

ความลำเอียงนี้ทำให้เกิดความมั่นใจมากเกินไปในความเชื่อส่วนตัวของตนและสามารถรักษาหรือแม้แต่ทำให้ตั้งมั่นยิ่งขึ้นซึ่งความเชื่อผิด ๆ แม้ว่าจะมีหลักฐานที่แสดงข้อเท็จจริงคัดค้านความเชื่อนั้น การตัดสินใจที่ไม่ดีเหตุความลำเอียงเหล่านี้ พบได้ทั้งในสถานการณ์ทางการเมืองและในองค์กรต่าง ๆ[B]

ประเภท[แก้]

ความลำเอียงเพื่อยืนยันเป็นปรากฏการณ์เกี่ยวกับการประมวลข้อมูลซึ่งต่างจากปรากฏการณ์ที่ยืนยันด้วยการกระทำ ที่เรียกว่า self-fulfilling prophecy (แปลว่า คำพยากรณ์ที่เป็นจริงในตัวเอง) ซึ่งพฤติกรรมที่เกิดจากความหวัง เป็นเหตุให้ความหวังนั้นกลายเป็นจริง[3] นักจิตวิทยาบางท่านใช้คำว่าความลำเอียงเพื่อยืนยัน เพื่อหมายถึงความโน้มน้าวที่จะหลีกเลี่ยงการยกเลิกความเชื่อเก่า ๆ ในขณะที่กำลังค้นหาหลักฐาน ตีความหมายหลักฐาน หรือระลึกถึงหลักฐานนั้น ๆ จากความจำ ส่วนนักจิตวิทยาพวกอื่นจำกัดการใช้คำนี้ในเรื่องการสั่งสมหลักฐานโดยเลือก (แต่สิ่งที่ยืนยันความเชื่อ)[4][C]

การหาข้อมูลอย่างลำเอียง[แก้]

งานทดลองต่าง ๆ พบเหมือน ๆ กันว่า มนุษย์มักตรวจสอบสมมติฐานจากทางด้านเดียว โดยค้นหาหลักฐานที่จะลงรอยกับสมมติฐานของตน[5][6] แทนที่จะสืบหาหลักฐานที่เกี่ยวข้องกันทั้งหมด มนุษย์มักตั้งคำถามเพื่อที่จะได้รับคำตอบเชิงบวกที่สนับสนุนสมมติฐานของตน[7]คือมักค้นหาผลที่จะเกิดขึ้นถ้าสมมติฐานของตนตรงกับความจริง ไม่ค้นหาผลที่เกิดขึ้นถ้าสมมติฐานของตนไม่ตรงกับความจริง[7] ยกตัวอย่างเช่น สำหรับบุคคลที่ใช้คำถามแบบถูกไม่ถูกเพื่อจะสืบหาตัวเลขที่สันนิษฐานว่าน่าจะเป็นเลข 3 อาจตั้งคำถามว่า "เลขนี้เป็นเลขคี่ใช่ไหม" บุคคลมักนิยมคำถามชนิดนี้ ซึ่งเป็นคำถามที่เรียกว่า การทดสอบเชิงบวก (positive test) แม้ว่าการใช้คำถามเชิงลบว่า "เลขนี้เป็นเลขคู่ใช่ไหม" ความจริงแล้วก็จะได้ข้อมูลที่เหมือนกัน[8] แต่ว่า ไม่ใช่หมายความว่า แต่ละคนจะตรวจสอบที่จะได้คำตอบเป็นบวกเสมอไป ในงานทดลองที่ผู้ร่วมการทดลองสามารถเลือกการตรวจสอบเทียมหรือการตรวจสอบที่จะให้วินิจฉัยความจริงได้ ผู้ร่วมการทดลองชอบใจการตรวจสอบที่จะให้วินิจฉัยความจริงได้[9][10]

นอกจากนั้นแล้ว ความชอบใจในการทดสอบเชิงบวกไม่ใช่เป็นความเอนเอียงโดยตรง เนื่องจากว่าการทดสอบเช่นนี้สามารถให้ข้อมูลที่ดี[11] แต่ว่า เมื่อรวมเข้ากับพฤติกรรมอื่น ๆ วิธีเช่นนี้สามารถใช้เพื่อยืนยันความเชื่อหรือสมมติฐานของตน ไม่ว่าความเชื่อนั้นจะเป็นความจริงหรือไม่[12] ในชีวิตจริง หลักฐานข้อมูลต่าง ๆ มักซับซ้อนและปรากฏคละกัน ยกตัวอย่างเช่น ข้อคิดเห็นต่าง ๆ ที่ขัดแย้งกันเองเกี่ยวกับบุคคลหนึ่ง แต่ละอย่างสามารถสนับสนุนได้โดยดูพฤติกรรมด้านหนึ่งของบุคคลนั้น[6] ดังนั้น การหาหลักฐานเพื่อที่จะสนับสนุนสมมติฐานหนึ่ง ๆ จึงมีโอกาสประสบผลสำเร็จสูง[12] ตัวอย่างหนึ่งก็คือ การตั้งคำถามสามารถมีผลต่อคำตอบได้โดยนัยสำคัญ[6] เช่นคำถามว่า "คุณมีความสุขในชีวิตสังคมของคุณหรือไม่" มักได้คำตอบเชิงบวกมากกว่าคำถามว่า "คุณไม่มีความสุขในชีวิตสังคมของคุณใช่ไหม"[13]

แม้แต่การเปลี่ยนแปลงคำถามเพียงเล็กน้อยสามารถมีผลต่อวิธีการที่ผู้ตอบเสาะหาข้อมูลเพื่อจะตอบและดังนั้น จึงมีผลต่อคำตอบ มีการแสดงให้เห็นอย่างนี้ โดยงานวิจัยที่สมมุติคดีฟ้องร้องเกี่ยวกับการปกครองของเด็ก[14] คือมีการให้ผู้ร่วมการทดลองอ่านความว่า ผู้ปกครอง "ก" มีความเหมาะสมพอประมาณในการเป็นผู้ปกครองเพราะเหตุหลายอย่างและผู้ปกครอง "ข" มีคุณสมบัติและคุณวิบัติที่เด่นหลายอย่าง เช่นมีความใกล้ชิดกับเด็กแต่มีอาชีพที่ต้องจากเด็กไปเป็นระยะเวลายาวนาน เมื่อถามว่า "ผู้ปกครองคนไหนควรจะได้รับสิทธิปกครองเด็ก" ผู้ร่วมการทดลองโดยมากเลือกผู้ปกครอง ข เพราะสืบหาแต่ลักษณะที่ดี ๆ แต่เมื่อถามว่า "ผู้ปกครองคนไหนไม่ควรจะได้รับสิทธิปกครองเด็ก" ผู้ร่วมการทดลองโดยมากก็เลือกผู้ปกครอง ข เช่นกัน เพราะสืบหาแต่ลักษณะที่เสีย ๆ ซึ่งโดยปริยายหมายความว่า ผู้ปกครอง ก ควรจะได้รับสิทธิปกครอง[14]

งานวิจัยที่คล้ายกันอื่น ๆ แสดงวิธีที่บุคคลต่าง ๆ เสาะหาข้อมูลประกอบด้วยความเอนเอียง แต่ว่า ความเอนเอียงสามารถจำกัดได้เพราะมนุษย์มีความชอบใจในข้อทดสอบที่เป็นกลางจริง ๆ ในการทดลองหนึ่ง ผู้ร่วมการทดลองให้คะแนนกับอีกคนหนึ่งว่าเป็นคนเปิดเผยหรือเป็นคนเก็บตัวโดยเลือกคำถามเพื่อสัมภาษณ์จากรายการที่ได้รับ ถ้าแนะนำผู้รับการสัมภาษณ์ว่าเป็นคนเก็บตัว ผู้ร่วมการทดลองก็จะเลือกคำถามที่ตั้งข้อสันนิษฐานว่าคนนั้นเป็นคนเก็บตัว เป็นต้นว่า "คุณไม่ชอบใจอะไรในงานปาร์ตี้ที่หนวกหู" แต่ว่าถ้าแนะนำว่า เป็นคนเปิดเผย คำถามที่เลือกเกือบทั้งหมดจะเป็นประเภทที่ตั้งข้อสันนิษฐานว่าคนนั้นเป็นคนเปิดเผยเป็นต้นว่า "คุณจะทำอย่างไรเพื่อจะเพิ่มสีสันให้กับงานปาร์ตี้ที่ไม่มีชีวิตชีวา" คำถามที่ชี้คำตอบอย่างนี้ไม่ได้ให้โอกาสผู้รับสัมภาษณ์ที่จะให้ข้อมูลที่พิสูจน์ว่าข้อสันนิษฐานนั้นผิดพลาด[15] ส่วนการทดลองนั้นอีกแบบหนึ่งให้คำถามที่เป็นกลาง ๆ มากกว่ากับผู้ร่วมการทดลองเพื่อให้เลือก เช่น "ปกติ คุณหลีกเลี่ยงการเข้าสังคมหรือไม่"[16] ปรากฏว่าผู้ร่วมการทดลอชอบใจที่จะถามคำถามที่สามารถให้หลักฐานวินิจฉัยที่ดีกว่าโดยมีความเอนเอียงเล็กน้อยเพียงเท่านั้นต่อคำถามแบบบวกความเป็นไปเช่นนี้ ที่มีความชอบใจต่อข้อทดสอบที่เป็นกลาง ๆ และมีความชอบใจต่อคำถามเชิงบวกเพียงเล็กน้อยก็พบในงานวิจัยอื่น ๆ อีกด้วย[16]

บุคลิกภาพมีอิทธิพลและทำงานร่วมกับกระบวนการค้นหาหลักฐานแบบลำเอียง[17] มนุษย์มีความสามารถต่าง ๆ กันในการยืนยันความคิดเห็นฝ่ายตนเมื่อคนอื่นคัดค้านโดยนัยว่า "ใช้หลักฐานตามเลือก" "เป็นการค้นหาแต่ข้อมูลที่เข้ากัน" และ "ไม่หาข้อมูลที่ไม่เข้ากัน"[18] งานทดลองหนึ่งตรวจสอบขอบเขตที่บุคคลสามารถหักล้างข้อโต้แย้งที่คัดค้านความความเชื่อฝ่ายตน[17] บุคคลที่มีความมั่นใจสูงมักสืบหาข้อมูลคัดค้านความคิดเห็นฝ่ายตนได้อย่างเต็มใจกว่าส่วนบุคคลที่มีความมั่นใจต่ำมักไม่ค้นหาข้อมูลที่ไม่เข้ากันแต่จะชอบใจข้อมูลที่สนับสนุนความคิดเห็นฝ่ายตนโดยย่อก็คือ มนุษย์มักค้นหาและประเมินหลักฐานจากหลักฐานที่มีความเอนเอียงไปทางความเชื่อหรือความเห็นฝ่ายตน[19] แต่ระดับความมั่นใจที่สูงจะช่วยลดความชอบใจในข้อมูลที่สนับสนุนความเชื่อส่วนตัว

งานทดลองอีกงานหนึ่งทดสอบผู้ร่วมการทดลองโดยให้ค้นหากฎการเคลื่อนไหวของวัตถุที่ซับซ้อนโดยสังเกตการเคลื่อนไหวของวัตถุที่จำลองโดยคอมพิวเตอร์[20] คือ วัตถุบนจอคอมพิวเตอร์จะเคลื่อนไหวตามกฎระเบียบอย่างหนึ่ง ซึ่งผู้ร่วมการทดลองต้องทำความเข้าใจโดย "ยิง" วัตถุต่าง ๆ ข้ามจอคอมพิวเตอร์เพื่อที่จะทดสอบสมมติฐานของตนแม้ว่าจะทำความพยายามตลอด 10 ช.ม. ไม่มีใครเลยที่สามารถทำความเข้าใจกฎระเบียบของระบบผู้รับการทดลองมักพยายามหาหลักฐานเพื่อยืนยันสมมติฐานของตน แต่ไม่พยายามหาหลักฐานที่คัดค้านและมักลังเลในการพิจารณาสมมติฐานอื่น ๆ แม้ว่าจะได้เห็นหลักฐานที่คัดค้านสมมติฐานของตน แต่ก็มักพยายามทำการทดสอบอย่างเดียวกันต่อ ๆ ไปและถึงแม้ว่าผู้ร่วมการทดลองบางคนจะได้รับคำอธิบายเกี่ยวกับวิธีการทดสอบสมมติฐานที่ถูกต้อง แต่คำอธิบายเหล่านี้กลับแทบไม่มีผลอะไร[20]

การตีความหมายแบบเอนเอียง[แก้]

—Michael Shermer[21]

ความลำเอียงเพื่อยืนยันไม่ได้จำกัดอยู่เพียงแค่การสั่งสมหลักฐาน แม้ว่าคนสองคนจะมีหลักฐานเดียวกัน แต่การตีความหมายอาจจะประกอบกับความเอนเอียง

คณะวิจัยที่มหาวิทยาลัยสแตนฟอร์ดทำการทดลองกับผู้ร่วมการทดลองที่มีความเห็นชัดเจนเกี่ยวกับโทษประหารชีวิต โดยที่ครึ่งหนึ่งเห็นด้วยอีกครึ่งหนึ่งคัดค้าน[22][23] ผู้ร่วมการทดลองแต่ละคนอ่านบทความงานวิจัยสองงาน งานแรกเป็นการเปรียบเทียบรัฐต่าง ๆ ในสหรัฐอเมริกาที่มีและไม่มีโทษประหารชีวิตและงานที่สองเป็นกา เปรียบเทียบอัตราการฆ่าคนตายในรัฐหนึ่ง ๆ ก่อนและหลังการออกกฎหมายลงโทษประหารชีวิต หลังจากการอ่านข้อความสั้น ๆ ของแต่ละงานวิจัย ก็จะถามผู้ร่วมการทดลองว่ามีความเห็นที่เปลี่ยนไปหรือไม่ หลังจากนั้น ก็ให้ผู้ร่วมการทดลองอ่านรายละเอียดของวิธีการในงานวิจัย และให้ผู้ร่วมการทดลองให้คะแนนว่า งานวิจัยนั้นทำได้ดีและน่าเชื่อถือแค่ไหน[22] แต่ว่าจริง ๆ แล้ว ผลงานวิจัยเหล่านั้นเป็นเรื่องกุขึ้น มีการบอกผู้ร่วมการทดลองครึ่งหนึ่งว่า มีงานวิจัยหนึ่งที่สนับสนุนว่ากฎหมายมีผลในการลดอัตราฆาตกรรม และงานวิจัยอีกงานหนึ่งแสดงว่ากฎหมายไม่มีผล ในขณะที่บอกผู้ร่วมการทดลองอีกครึ่งหนึ่งในนัยตรงกันข้าม[22][23]

ผู้ร่วมการทดลอง ไม่ว่าจะสนับสนุนหรือคัดค้านโทษประหารชีวิต รายงานว่าความเห็นได้เปลี่ยนไปเล็กน้อยตามหลักฐานที่แสดงในงานวิจัยแรก แต่หลังจากที่ได้อ่านรายละเอียดของงานวิจัยทั้งสอง เกือบทั้งหมดจะกลับไปที่ความคิดเห็นเดิมของตนโดยไม่ขึ้นกับหลักฐานที่ได้แล้วชี้รายละเอียดที่สนับสนุนข้อคิดเห็นของตนและทิ้งรายละเอียดอื่นที่คัดค้าน ผู้ร่วมการทดลองแสดงว่า งานวิจัยที่สนับสนุนความคิดเห็นของตนทำได้ดีกว่างานทดลองที่คัดค้าน โดยที่ผู้ร่วมการทดลองสามารถแสดงเหตุผลได้อย่างละเอียดและเฉพาะกรณี[22][24]

ผู้ที่สนับสนุนโทษประหารชีวิตกล่าวถึงงานวิจัยที่แสดงความที่กฎหมายไม่มีผลว่า "งานวิจัยสั่งสมข้อมูลในช่วงเวลาน้อยเกินไป" ในขณะที่ผู้คัดค้านโทษประหารชีวิตกล่าวถึงงานวิจัยเดียวกันว่า "ไม่มีหลักฐานสำคัญ (เพิ่มขึ้น) ที่จะมาคัดค้านผู้ทำงานวิจัย (ว่ากฎหมายมีผล)"[22] ผลงานวิจัยนี้แสดงว่า มนุษย์ใช้มาตรฐานที่สูงกว่าในการประเมินหลักฐานของสมมติฐานที่คัดค้านความคิดเห็นฝ่ายตน เป็นปรากฏการณ์ที่เรียกว่า ความเอนเอียงเพื่อคัดค้าน (disconfirmation bias) เป็นความเอนเอียงซึ่งพบในงานทดลองหลายงาน[25]

มีการทำอีกงานวิจัยหนึ่งเกี่ยวกับการตีความหมายแบบบเอนเอียงในระหว่างการเลือกตั้งประธานาธิบดีสหรัฐอเมริกา ค.ศ. 2004 ซึ่งทดสอบผู้ร่วมการทดลองผู้รายงานว่ามีความเห็นที่ชัดเจนเกี่ยวกับผู้สมัครรับเลือกตั้ง ผู้ร่วมการทดลองได้รับข้อมูลคำแถลงเป็นคู่ ๆ ที่ขัดแย้งกันจากผู้สมัครรับเลือกตั้งพรรคริพับลิกัน จอร์จ ดับเบิลยู. บุช และจากผู้สมัครรับเลือกตั้งพรรคเดโมแครต จอห์น เคอร์รี่ หรือจากคนมีชื่อเสียงอื่นที่เป็นกลางทางการเมือง นอกจากนั้น มีการให้คำแถลงอื่น ๆ ที่ทำให้ข้อมูลที่ขัดแย้งกันดูเหมือนมีเหตุผลจากข้อมูล 3 อย่างเหล่านี้ ผู้ร่วมการทดลองต้องตัดสินใจว่า คำพูดของแต่ละคนขัดแย้งกันเองหรือไม่[26]: 1948 มีความแตกต่างกันอย่างสำคัญในข้อตัดสินของผู้ร่วมการทดลอง คือมีโอกาสมากกว่าที่จะตีความหมายของคำพูดจากผู้สมัครรับเลือกตั้งที่ตนคัดค้านว่าขัดแย้งกันเอง[26]: 1951

ในการทดลองนี้ ผู้ร่วมการทดลองทำการตัดสินใจเมื่ออยู่ในเครื่องเอ็มอาร์ไอซึ่งตรวจดูการทำงานในสมอง เมื่อผู้ร่วมการทดลองกำลังประเมินคำพูดที่ขัดแย้งกันของผู้สมัครรับเลือกตั้งที่ตนสนับสนุน ศูนย์อารมณ์ในสมองจะเกิดการเร้า แต่จะไม่มีการเร้าเมื่อกำลังประเมินคำพูดของผู้สมัครรับเลือกตั้งที่ตนคัดค้านผู้ทำงานวิจัยอนุมานผลนี้ว่า ปฏิกิริยาที่แตกต่างกันต่อคำพูดที่ขัดแย้งกันไม่ได้เกิดจากความผิดพลาดในการคิดหาเหตุผลอย่าง passive แต่ว่า ผู้ร่วมการทดลองต้องทำการลดระดับความขัดแย้งกันทางปริชาน (cognitive dissonance) ที่เกิดจากการรับรู้พฤติกรรมที่ไม่สมเหตุสมผลหรือหน้าไหว้หลังหลอกของผู้สมัครรับเลือกตั้งที่ตนสนับสนุนอย่างแอ๊กถีฟ

ความเอนเอียงในการตีความหมายเกี่ยวกับความเชื่อนั้นฝังแน่น ไม่ว่าจะฉลาดแค่ไหน ในการทดลองหนึ่ง ผู้ร่วมการทดลองทำข้อทดสอบ SAT เพื่อตรวจสอบสติปัญญา หลังจากนั้น ก็ให้อ่านข้อมูลเกี่ยวกับความปลอดภัยของรถโดยสารที่นักวิจัยจะกุข้อมูลเกี่ยวประเทศกำเนิดของรถ ผู้ร่วมการทดลองชาวอเมริกันต้องให้คะแนนเป็น 6 แต้มว่ารถคันนั้นควรห้ามไม่ให้ใช้หรือไม่ โดย 1 คะแนนเป็นการ "ห้ามเด็ดขาด" และ 6 เป็นการ "ไม่ห้ามเด็ดขาด" ผู้ร่วมการทดลองต้องประเมินว่าจะให้ใช้รถเยอรมันอันตรายในถนนคนอเมริกัน และรถอเมริกันอันตรายในถนนคนเยอรมันหรือไม่ ปรากฏว่า ผู้ร่วมการทดลองเชื่อว่า ควรห้ามรถเยอรมันอันตรายในถนนคนอเมริกัน อย่างรวดเร็วกว่าควรห้ามรถอเมริกันอันตรายในถนนคนเยอรมันและไม่ปรากฏว่าระดับสติปัญญามีผลต่อคำตอบของผู้ร่วมการทดลอง[19]

การตีความหมายแบบเอนเอียงไม่ได้จำกัดอยู่ในประเด็นที่ทำให้เกิดอารมณ์เพียงเท่านั้น ในอีกการทดลองหนึ่ง ผู้วิจัยบอกผู้ร่วมการทดลองเกี่ยวกับการลักขโมยเหตุการณ์หนึ่ง ผู้ร่วมการทดลองต้องกำหนดความสำคัญทางหลักฐานของข้อความที่เสนอว่า บุคคลหนึ่งเป็นขโมยหรือไม่ใช่ เมื่อผู้ร่วมการทดลองสันนิษฐานว่า บุคคลหนึ่งเป็นผู้มีความผิด ก็จะกำหนดข้อความที่สนับสนุนข้อสันนิษฐานของตนว่ามีความสำคัญมากกว่าข้อความที่แสดงความขัดแย้ง[27]

ความทรงจำที่เอนเอียง[แก้]

แม้ว่า บุคคลหนึ่งอาจจะสั่งสมและตีความหมายหลักฐานโดยความเป็นกลาง แต่ก็อาจจะเลือกระลึกถึงหลักฐานเหล่านั้นเพื่อที่จะส่งเสริมความคิดเห็นฝ่ายตน[28] ปรากฏการณ์นี้เรียกว่า การเลือกจำ (selective recall) ทฤษฎีทางจิตวิทยาต่าง ๆ มีพยากรณ์ที่แตกต่างกันในเรื่องการเลือกจำ ทฤษฏีโครงสร้างความรู้ (Schema theory) พยากรณ์ว่า ข้อมูลที่ตรงกับความคาดหมายที่มีมาก่อนจะสามารถจำและระลึกได้ดีกว่าข้อมูลที่ไม่ตรงกัน[29] ส่วนทฤษฎีอื่นบอกว่า ข้อมูลที่ทำให้ประหลาดใจจะเด่นกว่าและดังนั้นจึงจำได้ดีกว่า[29] คำพยากรณ์จากทั้งสองทฤษฎีที่กล่าวมานั้นได้รับการยืนยันจากการทดลองที่มีรูปแบบที่ต่างกัน ดังนั้นจึงไม่ปรากฏทฤษฎีที่ชนะโดยเด็ดขาด[30]

ในอีกงานวิจัยหนึ่ง ผู้ร่วมการทดลองอ่านข้อความแสดงลักษณะของหญิงคนหนึ่งเป็นพฤติกรรมทั้งแบบเปิดเผยและเก็บตัว[31] หลังจากนั้น ก็จะต้องระลึกถึงตัวอย่างของความเป็นผู้เปิดเผยและความเป็นผู้เก็บตัว ผู้ร่วมการทดลองกลุ่มหนึ่งต้องประเมินหญิงนั้นสำหรับงานเป็นบรรณารักษ์ในขณะที่กลุ่มที่สองต้องประเมินหญิงนั้นเพื่องานเป็นนายหน้าขายที่ดิน สิ่งที่คนสองกลุ่มนี้ระลึกได้แตกต่างกันอย่างสำคัญคือ กลุ่มบรรณารักษ์ระลึกถึงตัวอย่างที่แสดงความเป็นคนไม่เปิดเผยได้มากกว่า ในขณะที่กลุ่มนายหน้าระลึกถึงตัวอย่างที่แสดงความเป็นคนเปิดเผยได้มากกว่า[31]

ผลของความจำเลือกสรรก็ปรากฏด้วยในงานทดลองต่าง ๆ ที่มีการกุความน่าปรารถนาของบุคลิกประเภทต่าง ๆ[29][32] ในงานทดลองหนึ่ง มีการแสดงหลักฐานกับผู้ร่วมการทดลองกลุ่มหนึ่งว่า ผู้มีบุคลิกเปิดเผยมีความสำเร็จในชีวิตมากกว่า ส่วนอีกกลุ่มหนึ่งมีการแสดงข้อมูลตรงกันข้าม ในงานทดลองต่อมาอีกงานหนึ่งซึ่งไม่ทำเชื่อมต่อกัน มีการให้ผู้ร่วมการทดลองระลึกถึงเหตุการณ์ในชีวิตที่ตนแสดงพฤติกรรมเปิดเผยหรือเก็บตน ผู้ร่วมการทดลองในแต่ละกลุ่มระลึกถึงเหตุการณ์ที่เชื่อมตนเองกับบุคลิกภาพที่น่าปรารถนาได้มากกว่า และระลึกถึงเหตุการณ์เหล่านั้นได้เร็วกว่า[33]

การประเมินถึงเหตุการณ์ที่เปลี่ยนไปสามารถมีผลต่อความทรงจำ[34] มีการให้ผู้ร่วมการทดลองลงคะแนนว่า ตนได้รู้สึกอย่างไรเมื่อรู้เป็นครั้งแรกว่า โอเจ ซิมป์สัน (อดีตนักกีฬาอเมริกันฟุตบอลชื่อดังผู้ถูกกล่าวหาว่าฆ่าภรรยาของตน) ได้รับการตัดสินว่าไม่ผิดในข้อหาฆาตกรรม[34] ผู้ร่วมการทดลองได้พรรณนาถึงความรู้สึกและความมั่นใจของตนในข้อตัดสินในช่วงหนึ่งอาทิตย์ สองเดือน และหนึ่งปีหลังจากการตัดสินคดี ผลแสดงว่า การประเมินความผิดผู้ต้องหาของผู้ร่วมการทดลองเปลี่ยนไปตามเวลาและถ้าความคิดเห็นของผู้ร่วมการทดลองยิ่งเปลี่ยนไปเท่าไร ความทรงจำของของผู้ร่วมการทดลองเกี่ยวกับความรู้สึกที่มีในเบื้องต้นก็จะไม่มีเสถียรภาพยิ่งขึ้นเท่านั้น เมื่อผู้ร่วมการทดลองระลึกถึงปฏิกิริยาทางอารมณ์ที่เกิดขึ้นที่สองเดือนและที่หนึ่งปีให้หลัง ความทรงจำว่ามีความรู้สึกอย่างไรในอดีต ก็จะขึ้นอยู่กับการประเมินเหตุการณ์นั้น ๆ ในปัจจุบัน[34] มนุษย์แสดงความลำเอียงเพื่อยืนยันเมื่อกล่าวถึงความคิดเห็นฝ่ายตนในประเด็นที่มีความเห็นขัดแย้งกัน[19]

ความเปลี่ยนแปลงทางอารมณ์ความรู้สึกสามารถมีผลต่อความทรงจำ[35] ในการทดลองหนึ่ง มีการให้พ่อหม้ายและแม่หม้ายให้คะแนนความรู้สึกเศร้าหกเดือนและห้าปีหลังจากการเสียชีวิตของคู่ครอง ผู้ร่วมการทดลองบอกว่า มีความรู้สึกเศร้าที่ช่วงหกเดือนในระดับที่สูงกว่าช่วงห้าปี แต่ว่า เมื่อถามผู้ร่วมการทดลองหลังห้าปีไปแล้วว่า มีความรู้สึกอย่างไรหกเดือนหลังจากการเสียชีวิตของคู่ครอง การให้คะแนนระดับความรู้สึกเศร้าที่ระลึกได้มีสหสัมพันธ์ในระดับสูงกับความรู้สึกปัจจุบันคือ มนุษย์ดูเหมือนจะใช้อารมณ์ความรู้สึกปัจจุบันเพื่อวิเคราะห์ว่าตนรู้สึกอย่างไรในอดีต[34] นั่นก็คือ ความทรงจำในอดีตที่ประกอบด้วยอารมณ์เกิดการสร้างขึ้นใหม่อาศัยอารมณ์ความรู้สึกในปัจจุบัน

งานวิจัยหนึ่งอธิบายว่า ความจำเลือกสรรสามารถดำรงรักษาความเชื่อในการรับรู้นอกเหนือประสาทสัมผัส (extrasensory perception ตัวย่อ ESP) เช่นการอ่านใจของผู้อื่นได้[36] คือ มีการแสดงคำพรรณนาถึงการทดลองเกี่ยวกับ ESP ให้ทั้งคนเชื่อและไม่เชื่อมีการบอกคนกึ่งหนึ่งของแต่ละกลุ่มว่า มีผลการทดลองที่สนับสนุนว่า ESP นั้นมีจริงและบอกอีกกึ่งหนึ่งว่า ผลการทดลองไม่สนับสนุนความมีอยู่ของ ESP เมื่อสอบถามผู้ร่วมการทดลองภายหลัง ผู้ร่วมการทดลองโดยมากสามารถระลึกถึงข้อมูลที่ได้รับอย่างแม่นยำ ยกเว้นคนเชื่อที่อ่านข้อมูลที่ไม่สนับสนุน ผู้ร่วมการทดลองกลุ่มนี้ระลึกถึงข้อมูลได้น้อยกว่ากลุ่มอื่นและบางคนแถมจำผิดอีกด้วยว่า ข้อมูลการทดลองสนับสนุน ESP (ตรงกับความเชื่อของตนว่า ESP มีจริง)[36]

ปรากฏการณ์ที่เกี่ยวข้องกัน[แก้]

ความเห็นที่สุดโต่งเพิ่มขึ้น[แก้]

เมื่อกลุ่มบุคคลที่มีความเห็นตรงกันข้ามกันตีความหมายข้อมูลหลักฐานใหม่ ๆ โดยมีความเอนเอียงความเห็นของกลุ่มคนเหล่านั้นสามารถเกิดความต่างที่ห่างกันยิ่งขึ้น นี้เรียกว่า "ความเห็นที่สุดโต่งเพิ่มขึ้น" (attitude polarization)[37] ปรากฏการณ์นี้เห็นได้โดยการทดลองที่เอาลูกบอลสีแดงและดำมาจากถุงหนึ่งหรือสองถุงที่ซ่อนอยู่ ผู้ร่วมการทดลองรู้ว่า ถุงหนึ่งมีลูกบอลสีดำ 60% สีแดง 40% และอีกถุงหนึ่งสีดำ 40% สีแดง 60% นักวิจัยได้ทำการตรวจดูว่าอะไรจะเกิดขึ้นถ้าเอาลูกบอลมีสีสลับกันออกมา ซึ่งเป็นลำดับการเอาออกมาที่ไม่ให้สามารถระบุถุงใดถุงหนึ่งได้ หลังจากที่เอาลูกบอลแต่ละลูกออกมา ให้ผู้ร่วมการทดลองในแต่ละกลุ่มบอกทางวาจาว่า ตนคิดว่ามีความเป็นไปได้เท่าไรที่ลูกบอลเหล่านี้ได้นำออกมาจากถุงใดถุงหนึ่ง ผู้ร่วมการทดลองมักเกิดความมั่นใจเพิ่มขึ้นเรื่อย ๆ เมื่อเอาลูกบอลแต่ละลูกออกมาก ไม่ว่าตอนแรกตนจะคิดว่ากำลังดึงลูกบอลออกมาจากถุงที่มีสีดำ 60% หรือสีแดง 60% ความน่าจะเป็นที่ผู้ร่วมการทดลองประเมินจะเพิ่มขึ้นเรื่อย ๆ ส่วนในผู้ร่วมการทดลองอีกกลุ่มหนึ่ง นักวิจัยให้ประเมินค่าความน่าจะเป็นหลังจากเอาลูกบอลออกมาหมดชุดแล้วเท่านั้น ไม่ใช่ประเมินหลังจากเอาลูกบอลแต่ละลูกออกมาเหมือนกลุ่มแรก กลุ่มนี้ไม่เกิดปรากฏการณ์ความเห็นที่สุดโต่งเพิ่มขึ้นซึ่งบอกเป็นนัยว่าปรากฏการณ์นี้ไม่ใช่เกิดขึ้นเพราะว่าคนสองพวกมีความเชื่อที่ขัดแย้งกันเท่านั้นแต่ว่าเกิดขึ้นเมื่อตนได้แสดงออกมาแล้วว่าตนเป็นพวกไหน[38]

การทดลองในแนวนี้ที่เป็นรูปธรรมมากกว่าก็คือการทดลองตีความหมายของมหาวิทยาลัยสแตนฟอร์ด ที่ผู้ร่วมการทดลองผู้มีความเห็นที่ชัดเจนเกี่ยวการลงโทษประหารอ่านข้อความเกี่ยวกับข้อมูลหลักฐานการทดลองที่ผสมผเสกัน ผู้ร่วมการทดลอง 23% รายงานว่า ความเห็นของตนนั้นยิ่งมั่นคงเพิ่มขึ้น และความเปลี่ยนแปลงที่ผู้ร่วมการทดลองรายงานเองเช่นนี้ มีสหสัมพันธ์ที่ชัดเจนกับความเชื่อในเบื้องต้น (คือยิ่งมีความเห็นเบื้องต้นที่ชัดเจนเท่าไร ระดับการเปลี่ยนแปลงความเห็นที่เพิ่มความมั่นคงก็มีมากขึ้นเท่านั้น)[22] ในงานวิจัยต่อ ๆ มา ผู้ร่วมการทดลองก็รายงานด้วยว่า ความเห็นของตนมั่นคงเพิ่มขึ้นแม้ว่าจะได้ข้อมูลที่ไม่ชัดเจน แต่ว่า การเปรียบเทียบความคิดเห็นโดยบททดสอบ (ที่เป็นปรวิสัย) ก่อนและหลังการรับข้อมูลใหม่ ไม่ได้แสดงความเปลี่ยนแปลงเป็นนัยสำคัญซึ่งบอกเป็นนัยว่า การเปลี่ยนแปลงที่เจ้าตัวรายงาน (ที่เป็นอัตวิสัย) อาจไม่ได้มีจริง ๆ[25][37][39]

โดยใช้ข้อมูลจากการทดลองเหล่านี้ ดีนนา คุห์น และโจเซ็ฟ ลาว สรุปว่า ความเห็นที่สุดโต่งเพิ่มขึ้นเป็นปรากฏการณ์ที่มีจริง ๆ แต่ไม่ใช่เป็นสิ่งที่ต้องเกิดขึ้นคือเลี่ยงไม่ได้ เพราะว่า เกิดขึ้นในสถานการณ์ที่มีจำนวนน้อยพวกเขาพบว่า มันเกิดขึ้นไม่ได้มีเหตุจากการรับหลักฐานใหม่ แต่เกิดจากเพียงแค่คิดถึงประเด็นนั้นเท่านั้น[37]

ชาลส์ เทเบอร์ และมิลตัน ล็อดจ์ เสนอว่า ผลของมหาวิทยาลัยสแตนฟอร์ดทำซ้ำได้ยากเพราะว่าประเด็นที่ใช้ในการทดลองที่ทำภายหลังมีลักษณะเป็นนามธรรมมากเกิดไป หรือว่า เป็นเรื่องสับสนมากเกินไปกว่าที่จะให้เกิดปฏิกิริยาทางอารมณ์ ดังนั้น งานวิจัยของเทเบอร์และล็อดจ์จึงใช้ประเด็นที่ก่อให้เกิดอารมณ์คือเรื่องกฎหมายควบคุมการมีปืน และเรื่องการยืนยันสิทธิประโยชน์ของคนบางพวก (affirmative action)[25] พวกเขาวัดทัศนคติของผู้ร่วมการทดลองเกี่ยวกับประเด็นเหล่านี้ก่อนและหลังการอ่านข้อโต้แย้งจากทั้งสองฝ่าย มีกลุ่มผู้ร่วมการทดลอง 2 กลุ่มที่เกิดความเห็นที่สุดโต่งเพิ่มขึ้น คือพวกที่มีความคิดเห็นที่มั่นคงมาก่อน และบุคคลที่มีความรู้ด้านการเมือง ในส่วนหนึ่งของงานวิจัยนี้ ผู้ร่วมการทดลองสามารถเลือกแหล่งกำนิดของหลักฐานที่จะอ่าน จากรายการที่นักวิจัยเป็นคนเตรียมขึ้น ยกตัวอย่างเช่นสามารถเลือกที่จะอ่านข้อมูลหลักฐานของสมาคมไรเฟิลแห่งชาติ (สหรัฐอเมริกา ซึ่งต่อต้านกฎหมายควบคุมการมีปืน) หรือของคณะต่อต้านปืนพกเบรดี (ซึ่งสนับสนุนกฎหมายควบคุม) แม้ว่าจะได้รับคำสั่งว่าให้มีใจเป็นกลาง ผู้ร่วมการทดลองมักอ่านหลักฐานข้อมูลที่สนับสนุนทัศนคติที่ตนมีอยู่มากกว่าที่คัดค้าน การแสวงหาข้อมูลที่มีความเอนเอียงเช่นนี้มีสหสัมพันธ์สูงกับความเห็นที่สุดโต่งเพิ่มขึ้น[25]

ปรากฏการณ์ผลตรงกันข้าม (backfire effect) เป็นชื่อของปรากฏการณ์ที่เมื่อได้รับหลักฐานที่คัดค้านความเชื่อฝ่ายตน มนุษย์กลับปฏิเสธหลักฐานนั้นแล้วตั้งมั่นอยู่ในความเชื่อนั้นเพิ่มขึ้น[40][41]

ความทนทานของความเชื่อที่ถูกหักล้างแล้ว[แก้]

สามารถจะอยู่รอดพ้นและอาจจะเพิ่มความแข็งแกร่งเพิ่มขึ้นแม้มีหลักฐานที่คนอื่นที่เป็นกลางจะต้องกล่าวว่า เป็นเหตุผลพอเพียงที่จะลดความเชื่อนั้นลง

สามารถจะอยู่รอดได้แม้หลักฐานที่เป็นที่ตั้งของความเชื่อนั้นจะถูกทำลายอย่างสิ้นเชิง"—ลี รอส และเครก แอนเดอร์สัน[42]

ความลำเอียงเพื่อยืนยันสามารถใช้อธิบายว่าทำไมความเชื่อบางอย่างสามารถที่จะอยู่รอดได้แม้ว่าหลักฐานที่เป็นที่ตั้งถูกหักล้างหมดแล้ว[43] ความทนทานของความเชื่อได้รับการแสดงในการทดลองเป็นชุด ๆ ใช้วิธีที่เรียกว่าการเปิดเผยหลังเหตุการณ์ (debriefing paradigm) คือ จะให้ผู้ร่วมการทดลองอ่านหลักฐานปลอมของสมมุติฐานหนึ่ง ๆ หลังจากนั้น ความเปลี่ยนแปลงทางทัศนคติจะได้รับการวัด ต่อจากนั้น ก็จะแสดงอย่างละเอียดว่าหลักฐานนั้นเป็นเรื่องปลอมแปลง จากนั้น ทัศนคติของผู้ร่วมการทดลองก็จะได้รับการวัดอีกครั้งหนึ่งเพื่อเช็คดูว่า ความเชื่อในเรื่องนั้นจะกลับไปสู่ระดับเดิมก่อนแสดงหลักฐานปลอมหรือไม่[42]

สิ่งที่พบโดยสามัญก็คือความเชื่อที่เกิดขึ้นเพราะหลักฐานปลอมนั้นไม่หมดไปแม้หลังจากมีการเปิดเผยอย่างละเอียด[44] ในการทดลองหนึ่ง ผู้ร่วมการทดลองต้องแยกแยะระหว่างจดหมายฆ่าตัวตายที่เป็นของจริงและของปลอม ผู้วิจัยให้คะแนนความแม่นยำโดยสุ่ม คือบอกบางคนว่าทำได้ดี และบอกคนอื่นว่าทำได้แย่มาก แม้ว่าหลังจากที่เปิดเผยวิธีการทดลองนี้อย่างละเอียด ผู้ร่วมการทดลองก็ยังอยู่ใต้อิทธิพลของคะแนนที่ให้แบบสุ่มนั้น คือ ยังคิดว่าตนเองเก่งกว่าหรือแย่กว่าคนอื่นโดยเฉลี่ยในการทำงานประเภทนั้น ขึ้นอยู่กับว่านักวิจัยกล่าวว่าได้คะแนนเท่าไร[45]

ในอีกงานวิจัยหนึ่ง ผู้ร่วมการทดลองอ่านเรื่องผลประเมินการทำงานของเจ้าหน้าที่ดับเพลิงสองคน รวมถึงผลข้อทดสอบเกี่ยวกับการเลี่ยงความเสี่ยง[42] ผลการทดลองที่กุขึ้นนี้ แสดงความสัมพันธ์ไม่ลบก็บวกคือ มีการบอกผู้ร่วมการทดลองพวกหนึ่งว่า เจ้าหน้าที่ดับเพลิงที่เสี่ยงอันตรายมีผลงานดีกว่า และบอกอีกพวกหนึ่งว่า เจ้าหน้าที่ดับเพลิงที่เสี่ยงอันตรายมีผลงานด้อยกว่าผู้เลี่ยงความเสี่ยง[46] จริง ๆ แล้ว แม้ถ้าผลประเมินเหล่านี้ไม่ได้เป็นเรื่องที่กุขึ้น แต่หลักฐานที่ให้ก็ไม่ใช่หลักฐานที่ได้มาตรฐานทางวิทยาศาสตร์เพื่อจะสรุปประเด็นเกี่ยวกับผลงานของเจ้าหน้าที่ดับเพลิง อย่างไรก็ดี ผู้ร่วมการทดลองกลับเห็นว่าผลประเมินนั้นน่าเชื่อถือ[46]

เมื่อบอกผู้รับการทดลองว่า ผลประเมินเหล่านี้เป็นเรื่องปลอมแปลง ความเชื่อของผู้ร่วมการทดลองเกี่ยวกับความสัมพันธ์ที่ข้อมูลแสดงก็ลดลง แต่ว่า ประมาณครึ่งหนึ่งของผลทางความคิดที่เกิดจากผลประเมินกุนั้นกลับดำรงอยู่ได้[42] การสัมภาษณ์ผู้ร่วมการทดลองหลังจากนั้นแสดงว่า ผู้ร่วมการทดลองเข้าใจถึงเรื่องที่เปิดเผยและเชื่อว่าเป็นความจริง แต่กลับเห็นว่าหลักฐานที่ถูกหักล้างนั้นไม่มีความเกี่ยวข้องกับความเชื่อของตน ๆ (ทั้ง ๆ ที่ความจริงแล้วเหตุผลที่หลักฐานนั้นกุขึ้นมีผลต่อความคิดของผู้ร่วมการทดลอง)[46]

ความชอบใจต่อข้อมูลเบื้องต้น[แก้]

งานทดลองหลายงานพบว่า ข้อมูลต้น ๆ จากข้อมูลเป็นชุด ๆ มีน้ำหนักมากกว่าต่อมนุษย์ แม้ว่าลำดับข้อมูลจะไม่มีความสำคัญ ยกตัวอย่างเช่น บุคคลมักมีความประทับใจเชิงบวก กับบุคคลที่กล่าวว่ามีลักษณะ "ฉลาด ขยัน หุนหันพลันแล่น ปากร้าย ดื้อ มักริษยา" มากกว่าบุคคลที่มีลักษณะแบบเดียวกันแต่กล่าวถึงโดยลำดับกลับกัน[47] การให้ความสำคัญในอันดับแรกที่ไร้เหตุผล (irrational primacy effect) เป็นอิสระจากปรากฏการณ์ความสำคัญในลำดับของความทรงจำ (serial position effect) ซึ่งข้อมูลส่วนต้น ๆ ในลำดับสามารถระลึกถึงได้ดีกว่า[47] การตีความหมายแบบเอนเอียงสามารถอธิบายปรากฏการณ์นี้คือเมื่อเห็นข้อมูลส่วนเบื้องต้น มนุษย์จะตั้งสมมติฐานที่มีผลต่อการตีความหมายข้อมูลที่เหลือ[43]

งานวิจัยที่แสดงการให้ความสำคัญในอันดับแรกที่ไร้เหตุผลใช้ชิปสีที่บอกว่าจะมาจากอ่างสองใบ มีการบอกผู้ร่วมการทดลองว่า ชิปสีต่าง ๆ มีสัดส่วนเท่าไรในอ่างทั้งสอง และผู้ร่วมการทดลองจะต้องประมาณความน่าจะเป็นของชิปที่นำมาจากอ่างใบหนึ่ง[47] แต่จริง ๆ แล้วนักวิจัยแสดงชิปตามลำดับที่จัดไว้แล้ว ชิป 30 อันแรกดูเหมือนจะระบุอ่างใบหนึ่ง และ 30 อันต่อไประบุอ่างอีกใบหนึ่ง[43] โดยรวม ๆ แล้ว ชิปที่นำออกมาทั้งหมดเป็นกลาง ๆ ฉะนั้น โดยเหตุผลแล้ว อาจจะมาจากอ่างทั้งสองใบใดใบหนึ่งก็ได้ แต่หลังจากการแสดงชิป 60 อัน ผู้ร่วมการทดลองชอบใจอ่างที่ชิป 30 อันแรกดูเหมือนจะระบุ[47]

อีกการทดลองหนึ่งแสดงภาพสไลด์ชุดของวัตถุหนึ่งที่เป็นภาพมัวไม่ชัดตอนต้น ๆ และชัดขึ้นเรื่อย ๆ ในภาพต่อ ๆ มา[47] หลังจากแสดงแต่ละภาพ ผู้ร่วมการทดลองต้องเดาว่าวัตถุนั้นคืออะไรผู้ร่วมการทดลองที่เดาผิดตอนต้น ๆ กลับเดาเหมือนกันต่อไปเรื่อย ๆ แม้ว่า ภาพจะชัดจนกระทั่งคนอื่นสามารถบอกได้โดยง่ายว่าวัตถุนั้นคืออะไร[43]

ความสัมพันธ์ลวงระหว่างเหตุการณ์ต่าง ๆ[แก้]

สหสัมพันธ์ลวง (Illusory correlation) เป็นความโน้มน้าวที่จะเห็นความสัมพันธ์ที่ไม่มีจริง ๆ ในเซตข้อมูล[48] ความโน้มน้าวอย่างนี้ได้มีการแสดงเป็นครั้งแรกในชุดการทดลองในปลายคริสต์ทศวรรษ 1960[49] ในงานทดลองหนึ่ง ผู้ร่วมการทดลองอ่านเค้สทางจิตเวชชุดหนึ่ง รวมทั้งปฏิกิริยาต่อแบบทดสอบภาพหยดหมึกรอร์ชัค ผู้ร่วมการทดลองสรุปว่า ชายรักร่วมเพศในกรณีเหล่านั้นมีโอกาสสูงกว่าที่จะเห็นก้น รูทวารหนัก หรือรูปคลุมเครือทางเพศต่าง ๆ ในรูปหมึกจุดเหล่านั้น แต่ว่าจริง ๆ แล้วเป็นเรื่องกุขึ้น แถมในการทดลองหนึ่ง กรณีเหล่านั้นกุขึ้นโดยที่ชายรักร่วมเพศมีโอกาสน้อยกว่าที่จะเห็นภาพเป็นอย่างนั้น[48] ในการสำรวจอีกงานหนึ่ง (ที่ไม่มีการให้อ่านกรณีต่าง ๆ ที่กุขึ้น) นักจิตวิทยามีประสบการณ์สูงกลุ่มหนึ่งถึงกับรายงานความสัมพันธ์เทียมแบบนี้กับคนรักร่วมเพศ แม้ว่าความสัมพันธ์แบบนี้ไม่มีจริง ๆ[48][49]

งานวิจัยอีกงานหนึ่งบันทึกอาการของคนไข้ข้ออักเสบและสภาพภูมิอากาศในช่วงเวลา 15 เดือน คนไข้เกือบทั้งหมดรายงานว่า ความเจ็บปวดของตนมีความสัมพันธ์กับสภาพภูมิอากาศ ทั้งที่จริง ๆ แล้วระดับสหสัมพันธ์อยู่ที่ศูนย์[50]

ปรากฏการณ์นี้เป็นรูปแบบหนึ่งของการตีความหมายแบบเอนเอียง คือตีความหมายหลักฐานที่เป็นกลาง ๆ หรือมีผลลบว่าสนับสนุน (คือมีผลบวก) กับความเชื่อที่มีอยู่ของตน และมีความเกี่ยวข้องกับความเอนเอียงแบบอื่น ๆ ในการทดสอบสมมติฐาน[51]

ในการตัดสินว่าเหตุการณ์สองอย่าง เช่นความเจ็บป่วยและอากาศที่ไม่ดี มีความสัมพันธ์กันหรือไม่ มนุษย์มักให้น้ำหนักกับหลักฐานเชิงบวก ซึ่งในตัวอย่างที่ผ่านมานี้ เป็นความเจ็บปวดและอากาศที่ไม่ดี แต่ไม่ใส่ใจสังเกตการณ์อย่างอื่น ๆ (เช่นไม่เจ็บในวันที่อากาศไม่ดี หรือเจ็บในวันที่อากาศดี)[52] นี้มีความคล้ายกันกับการให้น้ำหนักกับการตรวจสอบสมมติฐานเชิงบวก[51] นี่อาจจะเกี่ยวข้องกับความจำเลือกสรรอีกด้วย คือ มนุษย์อาจจะมีความรู้สึกว่าเหตุการณ์ต่าง ๆ มีความสัมพันธ์กันเพราะว่าง่ายที่จะระลึกถึงวันที่เหตุการณ์ทั้งสองอย่างเกิดขึ้นพร้อม ๆ กัน[51]

| จำนวนวัน | มีฝน | ไม่มี |

|---|---|---|

| มีอาการข้ออักเสบ | 14 | 6 |

| ไม่มี | 7 | 2 |

ในตัวอย่างข้างบน ความจริงแล้ว อาการข้ออักเสบเกิดขึ้นบ่อยกว่าในวันที่ไม่มีฝน (คือใน 8 วันที่ไม่มีฝน มี 6 วันมีอาการข้ออักเสบเป็นอัตราส่วน 75%) แต่บุคคลมักให้ความสนใจกับจำนวนวันที่สูงโดยเปรียบเทียบที่มีทั้งฝนตกและเกิดอาการ (แต่มีอาการเพียงแค่ 67% ของวันที่ฝนตก) โดยไปใส่ใจเพียงแค่ช่องเดียวในตารางแทนที่จะใส่ใจในทั้งสี่ช่อง บุคคลสามารถสร้างความสัมพันธ์ผิด ๆ ซึ่งในกรณีนี้ เป็นการสัมพันธ์วันที่ฝนตกกับวันที่มีอาการข้ออักเสบ[53]

ความแตกต่างระหว่างบุคคล[แก้]

ในอดีตเคยเชื่อกันว่า ความเอนเอียงเพื่อยืนยันมีความสัมพันธ์เชิงผกผันกับสติปัญญาที่สูงกว่า แต่ว่า งานวิจัยต่าง ๆ กลับพบว่า ทักษะในการคิดอย่างมีเหตุผลมีอิทธิพลต่อความเอนเอียงมากกว่าระดับสติปัญญา[54] ความเอนเอียงนี้อาจเป็นเหตุให้ไม่สามารถทำการประเมินแนวคิดตรงกันข้ามอย่างมีประสิทธิภาพและประกอบด้วยเหตุผล งานวิจัยต่าง ๆ เสนอว่า ความเอนเอียงนี้เป็นความปราศจาก "การเปิดใจกว้าง" ซึ่งหมายถึงการเสาะหาอย่างจริง ๆ จัง ๆ ว่า แนวคิดเบื้องต้นนั้นอาจจะผิดพลาดได้[55] โดยทั่ว ๆ ไปแล้ว ความเอนเอียงนี้เกิดขึ้นในการศึกษาเชิงประสบการณ์ โดยเป็นการใช้หลักฐานสนับสนุนความคิดของตนเป็นจำนวนมากกว่าหลักฐานที่คัดค้าน[56]

งานวิจัยหนึ่งพบความแตกต่างระหว่างบุคคลเกี่ยวกับความเอนเอียงนี้ โดยตรวจสอบความแตกต่างระหว่างบุคคลที่เกิดขึ้นจากการเรียนรู้ในวัฒนธรรม ซึ่งเป็นความแตกต่างที่เปลี่ยนไปได้ นักวิจัยพบความแตกต่างกันที่สำคัญในระหว่างบุคคลเกี่ยวกับความสามารถในการโต้แย้ง (วิธีการให้เหตุผล) งานวิจัยต่าง ๆ เสนอว่า ความแตกต่างในระหว่างบุคคลเช่น ความสามารถในการหาเหตุผลเชิงนิรนัย (deductive) ความสามารถในการเอาชนะความเอนเอียงเพราะความเชื่อ ความเข้าใจทางญาณวิทยา (เกี่ยวกับความรู้และฐานของความรู้เป็นต้น) และอัธยาศัยในการคิด เป็นตัวพยากรณ์สำคัญในการคิดหาเหตุผลและอ้างเหตุผล ในการโต้ตอบด้วยเหตุผล (counterargument) และในการพิสูจน์ความไม่จริง (rebuttal)[57][58][59]

งานวิจัยโดยคริสโตเฟอร์ วูลฟ์ และแอนน์ บริตต์ ตรวจสอบว่า ความเห็นของผู้รับการตรวจสอบว่า "อะไรเป็นวิธีการโต้แย้งที่ดี" สามารถเป็นต้นกำเนิดของความเอนเอียงเพื่อยืนยัน ที่มีอิทธิพลต่อวิธีที่บุคคลสร้างคำโต้แย้ง[56] คือ งานวิจัยตรวจสอบความแตกต่างของวิธีการโต้แย้งระหว่างบุคคลและกำหนดให้ผู้รับการทดลองเขียนบทความ โดยมีการจัดโดยสุ่มให้ผู้ร่วมการทดลองเขียนบทความสนับสนุนหรือคัดค้านข้อโต้แย้งฝ่ายตนโดยมีกำหนดให้เขียนบทความที่สมดุลหรือไม่มีกำหนดคือคำสั่งสมดุลบอกให้ผู้ร่วมการทดลองเขียนข้อโต้แย้งที่สมดุลที่กล่าวถึงทั้งข้อความที่สนับสนุนและข้อความที่คัดค้านและคำสั่งไม่มีกำหนดไม่กำหนดว่าควรจะเขียนข้อโต้แย้งอย่างไร

โดยรวม ๆ แล้ว ผลแสดงว่า คำสั่งสมดุลเพิ่มการใช้ข้อมูลคัดค้านในข้อโต้แย้งของผู้ร่วมการทดลองอย่างมีนัยสำคัญนอกจากนั้นแล้ว ข้อมูลงานวิจัยยังแสดงว่า ความเชื่อส่วนตัวไม่ใช่แหล่งกำเนิดของความลำเอียงเพื่อยืนยันคือ ผู้ร่วมการทดลองที่เชื่อคำพูดว่า ข้อโต้แย้งที่ดีต้องมีฐานจากความจริงมักปรากฏความเอนเอียงนี้มากกว่าผู้ที่ไม่เห็นด้วยกับคำพูดนี้ หลักฐานนี้สอดคล้องกับข้อเสนอในบทความของบารอนว่า ความเห็นในเรื่องการหาเหตุผลที่ดีมีอิทธิพลต่อการสร้างคำโต้แย้ง[56]

ประวัติ[แก้]

ข้อสังเกตในยุคต้น ๆ[แก้]

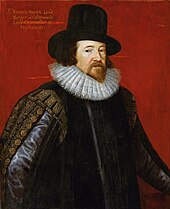

ก่อนที่จะมีการศึกษาทางจิตวิทยาในเรื่องความลำเอียงเพื่อยืนยัน มีนักเขียนหลายท่านที่ได้สังเกตเห็นปรากฏการณ์นี้รวมทั้งนักประวัติศาสตร์ชาวกรีกทิวซิดิดีส (460– 395 ก่อนคริสต์ศักราช), กวีชาวอิตาเลียนดันเต อาลีกีเอรี (ค.ศ. 1265–1321), นักปราชญ์และนักวิทยาศาสตร์ชาวอังกฤษฟรานซิส เบคอน (ค.ศ. 1561–1626),[60] และนักเขียนชาวรัสเซียเลโอ ตอลสตอย (ค.ศ. 1828–1910) ทิวซิดิดีสเขียนในหนังสือสงครามเพโลพอนนีส ว่า "...มันเป็นนิสัยมนุษย์ที่จะวางใจไว้ในความหวังที่ไร้เหตุผลที่ตนต้องการ และใช้เหตุผลเป็นผู้พิพากษาในการผลักไสสิ่งที่ตนไม่ชอบใจออกไป"[61] ในหนังสือดีวีนากอมเมเดีย ทอมัส อไควนัสเตือนดันเตเมื่อพบกันในสวรรค์ว่า "ความเห็น...ที่หุนหันพลันแล่น...มักเอนเอียงไปในข้างที่ผิด หลังจากนั้นความรักใคร่ในความเห็นของตนก็จะมัดและกักตัวความคิดไว้ (ในความเห็นผิดนั้น ๆ)"[62] ส่วนเบคอนเขียนไว้ว่า

ความเข้าใจของมนุษย์เมื่อได้ลงความเห็นแล้ว

ก็จะดึงทุกสิ่งทุกอย่างอื่นเพื่อที่จะสนับสนุนและปรับให้เข้ากับความเห็นนั้น และแม้ว่าจะมีหลักฐานมากกว่าโดยทั้งจำนวนและทั้งน้ำหนักของความเห็นด้านตรงกันข้าม

แต่ว่า ความเห็นนั้นก็จะถูกมองข้ามหรือดูถูก หรือว่าถูกวางเอาไว้ก่อนหรือปฏิเสธโดยอ้างเหตุผลบางอย่าง[63]

เบคอนกล่าวไว้ว่า การประเมินหลักฐานแบบเอนเอียงนำไปสู่ "ความเชื่อไร้เหตุผลทั้งหมด ไม่ว่าจะเป็นเรื่องโหราศาสตร์ ความฝัน ลาง การตัดสินของพระเจ้า หรือเรื่องที่คล้ายกันอื่น ๆ"[63]

ในบทความชื่อว่า "What Is Art? (อะไรเรียกว่าศิลปะ)" ตอลสตอยได้เขียนไว้ว่า

ผมรู้ว่าคนโดยมาก ไม่ใช่เพียงแต่ผู้ที่คนถือว่าฉลาด แต่แม้แต่ผู้ที่ฉลาดมาก ๆ

เป็นผู้สามารถที่จะเข้าใจปัญหาทางวิทยาศาสตร์ คณิตศาสตร์ และปรัชญาที่ยากที่สุด น้อยครั้งสามารถจะแยกแยะความจริงที่ง่ายที่สุดที่ชัดที่สุด ถ้าการกระทำอย่างนั้นบีบบังคับคนเหล่านั้นให้ต้องยอมรับความผิดพลาดของข้อสรุปที่ตนเป็นคนตั้ง ซึ่งอาจจะตั้งขึ้นด้วยความยากยิ่ง เป็นข้อสรุปที่ตนมีความภูมิใจ ที่ตนสอนให้กับคนอื่น

เป็นฐานที่ตนได้สร้างชีวิตของตนขึ้น[64]

งานวิจัยของวาสันเรื่องการทดสอบสมมติฐาน[แก้]

นักจิตวิทยาชาวอังกฤษปีเตอร์ วาสันได้บัญญัติคำว่า confirmation bias ไว้[65] คือในผลงานทดลองที่พิมพ์ในปี ค.ศ. 1960 เขาได้ท้าทายให้ผู้ร่วมการทดลองระบุสูตรที่กำหนดระเบียบของตัวเลขชุดละสาม ในเบื้องต้น เขาบอกว่า (2,4,6) มีระเบียบนี้ หลังจากนั้น ก็ให้ผู้ร่วมการทดลองตั้งเลขสามตัวขึ้นเพื่อให้ผู้ทำการทดลองบอกว่า อยู่ในระเบียบนี้หรือไม่[66][67]

ในขณะที่สูตรจริง ๆ ที่ใช้เป็นสูตรง่าย ๆ ว่า "เป็นลำดับเลขที่เพิ่มขึ้น" ผู้ร่วมการทดลองกลับประสบความยากลำบากอย่างยิ่งในการกำหนดสูตรนั้นและมักหาสูตรที่มีความเฉพาะเจาะจงเป็นอย่างยิ่ง เช่น "เลขตัวกลางเป็นค่าเฉลี่ยของเลขต้นและเลขปลาย"[66] ดูเหมือนว่า ผู้ร่วมการทดลองจะทดสอบตัวอย่างในเชิงบวกเท่านั้น คือตั้งเลขสามตัวที่ใช้สูตรที่ตนตั้งขึ้นเป็นสมมติฐาน ยกตัวอย่างเช่น ถ้าคิดว่าสูตรคือ "เลขแต่ละตัวบวกสองจากเลขตัวก่อน" ก็จะให้เลขสามตัวที่เข้ากับสูตรนี้เช่น (11,13,15) แต่ไม่ให้เลขสามตัวที่ไม่เข้ากัน เช่น (11,12,19)[68]

วาสันเป็นผู้ยอมรับความคิดเรื่อง falsificationism ซึ่งแสดงว่า การทดสอบสมมติฐานทางวิทยาศาสตร์เป็นความพยายามที่จริงจังที่จะพิสูจน์ว่าสมมติฐานนั้นผิด เขาตีความหมายของผลการทดลองนี้ว่า มนุษย์ชอบใจที่จะยืนยันความเห็นฝ่ายตนมากกว่าที่จะพิสูจน์ว่าผิด ดังนั้นจึงบัญญัติคำว่า "ความเอนเอียงเพื่อยืนยัน (confirmation bias)"[D] [69]

วาสันยังใช้ปรากฏการณ์ความเอนเอียงเพื่อยืนยันเพื่ออธิบายผลของการทดลองที่ใช้วิธี Wason selection task (แปลว่า งานเลือกของวาสัน) อีกด้วย[70] ในงานนี้ มีการให้ข้อมูลบางส่วนแก่ผู้ร่วมการทดลองเกี่ยวกับวัตถุจำนวนหนึ่งและผู้ร่วมการทดลองต้องกำหนดว่า มีข้อมูลอะไรอีกที่ต้องการเพื่อที่จะบอกว่ากฎมีเงื่อนไขเช่น "ถ้า ก ต้องเป็น ข" นั้น ถูกต้องมีการพบอย่างซ้ำ ๆ กันว่า มนุษย์ไม่สามารถทำงานแบบนี้ได้ดีคือโดยมากแล้ว มักไม่สนใจข้อมูลที่อาจจะพิสูจน์กฎนั้นว่าผิด[71][72]

คำวิจารณ์ของเคลย์แมนและฮา[แก้]

ในบทความปี ค.ศ. 1987 โจชัว เคลย์แมน และยังวอนฮา เสนอว่างานทดลองของวาสันไม่ได้แสดงความเอนเอียงเพื่อยืนยันจริง ๆ แต่ว่าพวกเขาอธิบายผลการทดลองของวาสันว่า มนุษย์มักทำการทดลองที่เข้ากับสมมติฐานที่ใช้งานอยู่[73] พวกเขาเรียกวิธีนี้ว่า "กลวิธีทดสอบเชิงบวก" (positive test strategy)[6] ซึ่งเป็นตัวอย่างของวิธีการศึกษาโดยทดลอง (heuristic) ซึ่งเป็นทางลัดในการหาเหตุผลที่ไม่สมบูรณ์แต่ง่ายที่จะทดสอบ[2]

เคลย์แมนและฮาใช้ความน่าจะเป็นแบบเบส์ (Bayesian probability) และทฤษฎีสารสนเทศ (information theory) เป็นมาตรฐานในการทดสอบสมมติฐาน แทนที่หลัก falsificationism ซึ่งต้องพยายามพิสูจน์ว่าสมมติฐานนั้นผิดตามที่วาสันใช้ แต่ว่าตามเคลย์แมนและฮา คำตอบของแต่ละคำถามให้ข้อมูลมากน้อยต่างกัน ขึ้นอยู่กับความคิดความเชื่อที่มีอยู่ก่อนดังนั้น การทดสอบสมมติฐานทางวิทยาศาสตร์จึงเป็นวิธีการทดสอบที่หวังว่าจะได้ข้อมูลมากที่สุดและการทดสอบเชิงบวกอาจจะให้ความรู้มากหรือน้อยขึ้นอยู่กับความน่าจะเป็นเบื้องต้นเคลย์แมนและฮาเสนอว่า เมื่อบุคคลกำลังขบปัญหาจริง ๆ ในโลก นั่นเป็นการหาคำตอบเฉพาะที่มีความน่าจะเป็นเบื้องต้นต่ำ (คือกฎธรรมชาติหรือคำอธิบายของธรรมชาติเป็นกฎเกณฑ์เฉพาะที่ไม่ได้เป็นกฎเกณฑ์แบบกว้าง ๆ) และในกรณีเช่นนี้ การทดสอบเชิงบวกจะให้ความรู้มากกว่าการทดสอบเชิงลบ (ดูแผนภาพเวนน์ภาพที่ 2 และ 3)[11]

แต่ว่า ในงานหาสูตรของวาสันซึ่งก็คือ เลขสามตัวที่เพิ่มขึ้นไปตามลำดับ เป็นกฎที่กว้างมาก (คือมีความน่าจะเป็นเบื้องต้นสูง ดูแผนภาพเวนน์ด้านซ้ายสุด) ดังนั้น โอกาสที่การทดสอบเชิงบวกจะให้ความรู้ที่ดีก็มีน้อย เคลย์แมนและฮาสนับสนุนการวิเคราะห์ของตนโดยอ้างงานทดลองที่ใช้ป้าย "DAX" และ "MED" สำหรับสูตรสองสูตรที่ผู้รับการทดลองต้องหา แทนที่ป้าย "เข้ากันกับสูตร" และ "ไม่เข้ากันกับสูตร" ซึ่งเป็นการป้องกันการบอกผู้รับการทดลองเป็นนัยว่า จุดมุ่งหมายก็เพื่อจะเสาะหาสูตร ๆ หนึ่งที่มีความน่าจะเป็นต่ำ ผลปรากฏว่า ผู้รับการทดลองประสบผลสำเร็จดีกว่าในรูปแบบนี้ของการทดลอง[74][75]

เพราะคำวิจารณ์นี้และอื่น ๆ จุดสนใจของงานวิจัยได้เปลี่ยนไปจากการทดสอบเชิงยืนยันและเชิงปฏิเสธไปเช็คดูว่า มนุษย์ตรวจสอบสมมติฐานโดยวิธีที่ให้เกิดความรู้ หรือว่าเป็นวิธีที่ไม่ทำให้เกิดความรู้แต่ว่าเป็นการทดสอบเชิงบวก การค้นหาความลำเอียงเพื่อยืนยัน "แท้" เป็นประเด็นทำให้นักจิตวิทยาทำการตรวจสอบปรากฏการณ์ต่าง ๆ เป็นจำนวนมาก เพื่อแสดงกระบวนการประมวลข้อมูลของมนุษย์[76]

คำอธิบาย[แก้]

บ่อยครั้งมีการอธิบายว่าความลำเอียงเพื่อยืนยันเป็นผลของกลยุทธ์อัตโนมัติ ที่ไม่ได้ประกอบด้วยความตั้งใจ และไม่ใช่เป็นการหลอกลวงโดยจงใจ[12][77] ตามนักวิจัยรอเบิรต์ แม็คคูน การประมวลผลแบบเอนเอียงโดยมากเป็นผลของการผสมผเสนกันของกลไกทางประชาน (cognitive) และกลไกเกี่ยวกับแรงจูงใจ (motivation)[78]

คำอธิบายความลำเอียงเพื่อยืนยันโดยกลไกทางประชาน มีฐานจากสมรรถภาพที่จำกัดของมนุษย์ในการทำงานที่ซับซ้อน และการใช้ทางลัดที่เรียกว่าวิธีการศึกษาโดยทดลอง (heuristic) ของมนุษย์[79] ยกตัวอย่างเช่น บุคคลอาจจะตัดสินความน่าเชื่อถือของหลักฐานโดยใช้ ฮิวริสติกโดยความเข้าถึงได้ง่าย คือว่า บุคคลคิดถึงสิ่งนั้นได้โดยง่าย ๆ แค่ไหน[80] และก็เป็นไปได้ด้วยที่ว่า มนุษย์สามารถใส่ใจในความคิดเดียวในช่วงเวลาหนึ่ง ๆ เท่านั้น ดังนั้น จึงยากที่จะทดสอบสมมติฐานหลาย ๆ อย่างไปพร้อม ๆ กัน[81] วิธีการศึกษาโดยทดลองอีกวิธีหนึ่งก็คือ กลยุทธ์ในการทดสอบเชิงบวกที่เคลย์แมนและฮาได้กล่าวถึง ที่มนุษย์ทดสอบสมมติฐานโดยเช็คกรณีที่หวังว่าจะเห็นลักษณะหรือเหตุการณ์ (เกี่ยวข้องกับสมมติฐานนั้น ๆ) การใช้วิธีการศึกษาโดยทดลองเป็นการเลี่ยงการต้องพิจารณาว่า คำถามแต่ละคำถามจะสามารถให้ข้อมูลได้เท่าไร ซึ่งเป็นเรื่องยากหรือเป็นไปไม่ได้แต่ว่า เพราะว่า ไม่ใช่เป็นวิธีที่ใช้ได้ดีเสมอไป ดังนั้น มนุษย์จึงอาจจะมองข้ามข้อมูลที่คัดค้านความเชื่อฝ่ายตน[11][82]

คำอธิบายโดยกลไกเกี่ยวกับแรงจูงใจเป็นการอธิบายถึงความหวังเกี่ยวกับความเชื่อนั้น ซึ่งบางครั้งเรียกว่า "ความคิดประกอบด้วยความหวัง" (wishful thinking)[83][84] เป็นที่รู้กันว่า มนุษย์ชอบใจความคิดที่ทำให้เกิดความรู้สึกที่ดี มากกว่าความคิดที่ทำให้เกิดความรู้สึกไม่ดี[85] เมื่อใช้กับการโต้แย้งและกับแหล่งกำเนิดหลักฐาน ก็จะสามารถอธิบายได้ว่าทำไมข้อสรุปที่ต้องการจึงมีโอกาสที่จะเกิดความเชื่อถือได้มากกว่า[83] ตามการทดลองที่จัดการเปลี่ยนแปลงความน่าปรารถนาของข้อสรุป มนุษย์มีมาตรฐานในการพิจารณาหลักฐานเกี่ยวกับความคิดที่กลืนไม่ลงที่สูงกว่าความคิดที่น่าชอบใจ[86][87]

แม้ว่า ความสม่ำเสมออาจจะเป็นคุณสมบัติที่น่าต้องการอย่างหนึ่งสำหรับการมีทัศนคติ แต่ว่า แรงผลักดันเพื่อความสม่ำเสมอมากเกินไปอาจจะเป็นแหล่งกำเนิดของความเอนเอียงอีกอย่างหนึ่ง เพราะว่า เป็นสิ่งที่ป้องกันบุคคลไม่ให้วางตัวเป็นกลางในการประเมินข้อมูลใหม่ ๆ ที่ไม่ตรงกับทัศนคตินั้น[83] นักสังคมจิตวิทยาซีวา คุนดา รวมทฤษฎีทางประชานและแรงจูงใจเข้าด้วยกันเพื่ออธิบายความเอนเอียงเพื่อยืนยัน โดยเสนอว่า แรงจูงใจนั้นนำไปสู่ความเอนเอียง แต่มีองค์ทางประชานที่กำหนดขนาดของความเอนเอียงนั้น[88]

ส่วนการอธิบายความเอนเอียงโดยใช้การวิเคราะห์ต้นทุน-ผลกำไร (cost-benefit analysis) ตั้งสมมติฐานว่า มนุษย์ไม่ได้ทดสอบสมมติฐานโดยไม่ได้คิดถึงผลประโยชน์ แต่จะประเมินถึงความเสียหายที่เกิดขึ้นจากความผิดพลาด (ของสมมติฐาน)[89] โดยใช้หลักจิตวิทยาวิวัฒนาการ (evolutionary psychology) เจมส์ ฟรีดริคเสนอว่า มนุษย์ไม่ได้ทดสอบสมมติฐานเพื่อหาความจริง แต่เพื่อจะหลีกเลี่ยงความผิดพลาดที่เกิดความเสียหายมากที่สุด ยกตัวอย่างเช่น ผู้ว่าจ้างอาจจะถามคำถามในแนวทางเดียวในการสัมภาษณ์งาน เพราะว่า ต้องโฟกั๊สในการที่จะกำจัดผู้สมัครที่ไม่เหมาะสมออกไป[90]

ยาคอฟ โทรป และอะกิวา ลีเบอร์แมนพัฒนาทฤษฎีนี้ขึ้นโดยตั้งสมมติฐานว่า บุคคลจะทำการเปรียบเทียบความผิดพลาดสองประเภท คือ การยอมรับสมมติฐานที่ผิด หรือการปฏิเสธสมมติฐานที่ถูก ยกตัวอย่างเช่น คนที่ตั้งค่าความซื่อสัตย์ของเพื่อนต่ำไปอาจจะมีการปฏิบัติกับเพื่อนด้วยความสงสัย ซึ่งเป็นการทำลายมิตรไมตรีนั้นส่วนการตั้งค่าสูงไปอาจจะเกิดความเสียหาย แต่ก็ไม่เท่ากับตั้งค่าต่ำไป ดังนั้นในกรณีนี้ จึงมีเหตุผลที่จะสืบหา ประเมิน และทรงจำหลักฐานที่แสดงความซื่อสัตย์อย่างมีความเอนเอียง[91]

เมื่อบุคคลหนึ่งปรากฏในเบื้องต้นว่าเป็นคนเปิดเผยหรือเป็นคนเก็บตัว การถามบุคคลนั้นโดยคำถามที่ตรงกับบุคลิก จะปรากฏว่า เป็นการเห็นใจผู้อื่น[92] นี้บอกเป็นนัยว่า เวลาคุยกับคนที่ดูเหมือนกับคนเก็บตัว อาจจะเป็นนิมิตว่ามีทักษะดีทางสังคมถ้าถามบุคคลนั้นว่า "คุณรู้สึกอึดอัดใจเวลาเข้าสังคมไหม" ที่ดีกว่าถ้าถามว่า "คุณชอบไปงานสังคมที่มีคนมาก ๆ ไหม"ความสัมพันธ์ระหว่างความลำเอียงเพื่อยืนยันและทักษะสังคมพบในงานทดลองที่ศึกษาวิธีการที่นักศึกษามหาวิทยาลัยทำความรู้จักกับคนอื่น ๆ คือ นักศึกษาที่เข้าใจตนเองดี ผู้มีความรู้สึกไวต่อสิ่งแวดล้อมและกฏเกณฑ์ของสังคม จะถามคำถามเมื่อสัมภาษณ์เจ้าหน้าที่มหาวิทยาลัยผู้มีฐานะสูง ที่เข้ากับผู้รับคำถามได้ดีกว่าเมื่อกำลังทำความรู้จักกับนักศึกษาด้วยกัน[92] (เพื่อที่จะให้เจ้าหน้าที่มหาวิทยาลัยมีความประทับใจในผู้ถาม)

นักจิตวิทยาเจ็นนิเฟอร์ เลอร์เนอร์ และฟิลิป เท็ทล็อก แบ่งกระบวนการคิดหาเหตุผลออกเป็นสองอย่าง คือ ความคิดแบบสำรวจ (exploratory thought) ที่พิจารณาแนวคิดต่าง ๆ อย่างเป็นกลาง ๆ โดยพยายามค้นหาข้อขัดแย้งต่อแนวคิดเหล่านั้นเท่าที่จะเป็นไปได้ ในขณะที่ความคิดเพื่อยืนยัน มีจุดประสงค์เพื่อจะหาหลักฐานสนับสนุนแนวคิดอย่างหนึ่ง เลอร์เนอร์และเท็ทล็อกกล่าวว่า เมื่อบุคคลคิดว่าจะต้องให้เหตุผลในจุดยืนของตนกับผู้อื่น ผู้มีทัศนคติที่บุคคลรู้แล้ว บุคคลมักถือเอาจุดยืนที่คล้ายกันกับของคนเหล่านั้น แล้วใช้ความคิดเพื่อยืนยันเพื่อเพิ่มความน่าเชื่อถือของบุคคล แต่ถ้าว่า ผู้อื่นนั้น มีความคิดรุนแรงหรือปากร้าย บุคคลจะเลิกคิดถึงเรื่องนั้น แล้วกล่าวเพียงแต่ความเห็นส่วนตัวของตนโดยไม่หาข้อยืนยัน[93] เลอร์เนอร์และเท็ทล็อกกล่าวว่า บุคคลจะกดดันให้ตนเองคิดอย่างรอบคอบอย่างมีเหตุผล เมื่อรู้ว่าจะต้องอธิบายความคิดของตนต่อผู้อื่น ที่รู้เรื่องดี สนใจในความจริง และมีทัศนคติที่บุคคลยังไม่รู้[94] แต่ว่า เพราะว่า เหตุการณ์ที่มีองค์ประกอบอย่างนี้มีน้อย ดังนั้น บุคคลจึงใช้ความคิดแบบยืนยันโดยมาก[95]

ผล[แก้]

เกี่ยวกับการเงิน[แก้]

ความลำเอียงเพื่อยืนยันอาจนำให้นักลงทุนมีความมั่นใจมากเกินไป โดยไม่ใส่ใจในหลักฐานว่ายุทธวิธีของตนจะทำให้ขาดทุน[96][97] ในงานวิจัยตลาดหลักทรัพย์เลือกตั้ง (จุดประสงค์เพื่อจะพยากรณ์ว่าใครจะได้รับเลือกตั้ง) นักลงทุนจะทำกำไรได้ดีกว่าถ้าพยายามฝืนความเอนเอียง ยกตัวอย่างเช่น นักลงทุนที่ประเมินผลการอภิปรายของผู้รับสมัครเลือกตั้งอย่างเป็นกลาง ๆ ไม่ใช่ตามแนวพรรคของตน มีโอกาสที่จะได้กำไรมากกว่า[98] เพื่อที่จะต่อต้านความเอนเอียงเพื่อยืนยัน นักลงทุนสามารถลองเปลี่ยนทัศนคติไปในแนวตรงกันข้ามเพื่อที่จะพัฒนาเหตุผลในทางความคิด[99] เทคนิคหนึ่งให้นักลงทุนจินตนาการว่า การลงทุนของตนเองจะล้มเหลวแล้วให้ถามตนเองว่า ทำไมเหตุการณ์นี้จึงเกิดขึ้น[96]

เกี่ยวกับสุขภาพกายและใจ[แก้]

นักจิตวิทยา เรย์มอนด์ นิกเกอร์สัน โทษความลำเอียงเพื่อยืนยันว่าเป็นเหตุของวิธีการรักษาทางการแพทย์ที่ไร้ผลที่ใช้มาเป็นศตวรรษก่อนที่จะเริ่มวิธีการแพทย์แบบวิทยาศาสตร์[100] คือ ถ้าคนไข้ฟื้นตัวขึ้น ผู้ปฏิบัติการทางแพทย์ก็เก็บคะแนนว่าการรักษามีผลแทนที่จะหาคำอธิบายอื่น ๆ เป็นต้นว่า โรคนั้นได้ดำเนินไปถึงที่สุดโดยธรรมชาติแล้ว[100] การรับข้อมูลแบบเอนเอียงเป็นองค์ประกอบหนึ่งของความดึงดูดใจของการแพทย์ทางเลือก ที่ผู้สนับสนุนมีความพอใจต่อหลักฐานโดยเรื่องเล่าที่แสดงผลดีของการรักษาแบบทางเลือก แต่ปฏิบัติต่อหลักฐานทางวิทยาศาสตร์โดยใช้มาตรฐานการประเมินที่สูงกว่า[101][102][103]

การบำบัดโดยประชาน (Cognitive therapy) เป็นวิธีการที่พัฒนาโดยจิตแพทย์ อารอน เบ็ก ในต้นคริสต์ทศวรรษ 1960 และได้กลายมาเป็นวิธีบำบัดรักษาที่นิยม[104] ตามความคิดของเบ็ก การประมวลข้อมูลแบบเอนเอียงเป็นองค์ประกอบของภาวะซึมเศร้า[105] เขาจึงสอนให้คนไข้พิจารณาชีวิตของตนอย่างเป็นกลาง ๆ ไม่ให้เลือกคิดแต่ในส่วนที่ไม่ดี[60] โรคกลัวและโรคคิดว่าตนป่วย มีความสัมพันธ์กับความลำเอียงเพื่อยืนยันข้อมูลที่น่ากลัว[106]

เกี่ยวกับการเมืองและกฎหมาย[แก้]

นิกเกอร์สันเสนอว่า การคิดหาเหตุผลในระบบการเมืองและระบบศาลบางครั้งมีความเอนเอียงแบบไม่รู้ตัว ไปในข้อสรุปที่ผู้พิพากศา ลูกขุน หรือเจ้าหน้าที่ของรัฐได้ถึงความตัดสินใจแล้ว[107] เนื่องจากว่า หลักฐานในคดีที่มีลูกขุนอาจจะมีความซับซ้อนและลูกขุนบ่อยครั้งลงเอยทำการตัดสินใจตั้งแต่ต้น ๆ ในการฟังคดีในศาลจึงสามารถสรุปอย่างสมควรว่า จะเกิดความเห็นที่สุดโต่งเพิ่มขึ้นในการว่าคดีที่เหลือ คำพยากรณ์ว่า ลูกขุนจะมีความเห็นสุดโต่งเพิ่มขึ้น เมื่อเห็นหลักฐานเพิ่มขึ้นเรื่อย ๆ เป็นจริงในงานทดลองด้วยคดีจำลอง[108][109] ความเอนเอียงเพื่อยืนยันมีอิทธิพลในกระบวนการยุติธรรมของคดีอาญาทั้งระบบไต่สวนและระบบกล่าวหา[110]

ความเอนเอียงเพื่อยืนยันเป็นองค์ในการให้กำเนิดการต่อสู้หรือทำให้การต่อสู้กันยาวนานยิ่งขึ้น เริ่มตั้งแต่การอภิปรายที่เกิดอารมณ์สูงจนกระทั่งถึงศึกสงคราม โดยตีความหมายอย่างเอนเอียงว่าหลักฐานสนับสนุนเหตุผลฝ่ายตน แต่ละฝ่ายอาจจะมีความมั่นใจมากเกินไปว่าจุดยืนฝ่ายตนดีกว่า[111] ในนัยตรงกันข้าม ความเอนเอียงเพื่อยืนยันอาจมีผลเป็นการไม่ใส่ใจหรือตีความหมายผิดซึ่งนิมิตว่าความขัดแย้งหรือการสงครามกำลังจะเกิดขึ้น ยกตัวอย่างเช่น นักจิตวิทยาสต๊วร์ต ซัธเธอร์แลนด์และโทมัส กิดา ต่างเสนอว่า พลเรือเอกสหรัฐฮัสแบนด์ กิมเมล มีความเอนเอียงเพื่อยืนยันเมื่อตัดความสำคัญของหลักฐานว่า ประเทศญี่ปุ่นจะโจมตีท่าเรือเพิร์ล[71][112]

ในงานวิจัยเกี่ยวกับผู้เชี่ยวชาญทางการเมืองเป็นเวลา 2 ทศวรรษ เท็ทล็อกได้พบว่า โดยรวม ๆ แล้ว คำพยากรณ์ของผู้เชี่ยวชาญเหล่านั้นไม่แม่นเกินความบังเอิญ คือ เท็ทล็อกแบ่งพวกนักเชี่ยวชาญออกเป็นสองกลุ่ม กลุ่ม "สุนัขจิ้งจอก" ที่มีสมมติฐานหลายอย่าง และกลุ่ม "เฮดจ์ฮอก" ที่หัวรั้นมากกว่าโดยทั่ว ๆ ไปคำพยากรณ์ของกลุ่มเฮดจ์ฮอกจะแม่นน้อยกว่าเท็ทล็อกโทษความล้มเหลวของผู้เชี่ยวชาญกลุ่มนี้ว่าเกี่ยวกับความลำเอียงเพื่อยืนยัน ซึ่งโดยเฉพาะก็คือ ความไม่สามารถที่จะใช้ข้อมูลใหม่ ๆ ที่ขัดแย้งกับทฤษฎีของตน[113]

ในคดีฆาตกรรมปี ค.ศ. 2013 ของนายตำรวจรัฐอินดีแอนาเดวิด แคมม์ ฝ่ายผู้ต้องหาเสนอว่า แคมม์ถูกโจทก์ว่าฆ่าภรรยาและลูกทั้งสองของตน เพราะเหตุแห่งความลำเอียงเพื่อยืนยันของผู้สอบสวนคดีเท่านั้น[114] คือ แคมม์ถูกจับ 3 วันหลังจากฆาตกรรมโดยอาศัยหลักฐานที่ผิดพลาด แม้ว่าจะพบภายหลังว่า หลักฐานที่ให้ในการออกหมายจับล้วนแต่ผิดพลาดหรือเชื่อถือไม่ได้ แต่ว่าฝ่ายโจทก์ก็ไม่ยอมถอนการฟ้อง[115][116] นอกจากนั้นแล้ว ยังมีการพบเสื้อแขนยาวในที่เกิดเหตุที่ภายหลังพบว่ามีดีเอ็นเอของผู้กระทำผิดคดีอาญาอีกคนหนึ่ง แถมเสื้อยังมีชื่อเล่นในคุกและเลขนักโทษของเขาบนเสื้ออีกด้วย[117] และเจ้าหน้าที่สอบสวนคดีได้สืบหาดีเอ็นเอของแคมม์บนเสื้อ แต่ไม่ได้ตรวจสอบหลักฐานอื่น ๆ ที่มีบนเสื้อ ไม่ได้เช็คดีเอ็นเออื่นผ่านระบบฐานข้อมูลของสำนักงานสอบสวนกลางจนกระทั่ง 5 ปีให้หลังจากเหตุเกิด[118][119] หลังจากพบผู้ต้องสงสัยคนที่สอง ฝ่ายโจทก์กลับกล่าวหาผู้ต้องสงสัยทั้งสองว่ารวมหัวกันในการฆาตกรรม แม้ว่าจะไม่ได้พบหลักฐานอะไร ๆ ที่เชื่อมชายทั้งสอง[120][121] แต่สุดท้ายนายตำรวจแคมม์ก็หลุดจากคดี[122]

เรื่องเหนือธรรมชาติ[แก้]

องค์ประกอบอย่างหนึ่งที่จูงใจคนให้เชื่อหมอดูทั้งหลายก็คือ คนฟังมีความลำเอียงเพื่อยืนยันโดยทำสิ่งที่หมอดูพูดให้เข้ากับชีวิตของตน[123] คือ เพราะว่ามีการกล่าวคำที่ไม่ชัดเจนเป็นจำนวนมากในการดูหมอแต่ละครั้ง หมอดูให้โอกาสแก่คนฟังเพื่อที่จะหาเรื่องที่เข้ากันกับตน นี้เป็นเทคนิคอย่างหนึ่งของการดูหมอแบบอ่านใจคน (cold reading) ที่หมอดูสามารถกล่าวคำที่ตรงกับผู้ฟังอย่างน่าอัศจรรย์ใจโดยที่ไม่มีข้อมูลอะไร ๆ ของคนฟังมาก่อนเลย[123]

นักตรวจสอบเจมส์ แรนดี้ (ผู้มีชื่อเสียงในการแสดงเรื่องเหนือธรรมชาติว่าไม่เป็นจริงหรือเป็นเรื่องหลอกลวง) เปรียบเทียบบันทึกการดูหมอกับสิ่งที่คนให้ดูบอกว่า หมอบอกว่าอะไร แล้วพบว่า ผู้ให้ดูมีความทรงจำแบบเลือกสรรในระดับสูงในข้อความที่ถูก (แต่จำไม่ได้ถึงข้อความที่ผิด)[124]

โดยใช้เป็นตัวอย่างที่เด่นเกี่ยวกับความเอนเอียงในโลกจริง ๆ นิกเกอร์สันกล่าวถึงความเชื่อเกี่ยวกับพีระมิดที่มักหาความหมายในสัดส่วนต่าง ๆ ชองพีระมิดชาวอียิปต์[125] คือ มีขนาดต่าง ๆ มากมายที่วัดได้ในพีรามิดหนึ่ง ๆ เช่นมหาพีระมิดแห่งกีซา และมีวิธีมากมายที่จะรวมหรือดัดแปลงขนาดต่าง ๆ เหล่านั้น ดังนั้น จึงเกือบจะหลีกเลี่ยงไม่ได้ที่คนที่เสาะหาดูเลขต่าง ๆ เหล่านี้โดยเลือก จะพบตัวเลขที่ตรงกับเลขอะไรอย่างหนึ่งที่เป็นความจริง เช่นขนาดของโลก[125]

ในวิทยาศาสตร์[แก้]

ลักษณะเด่นอย่างหนึ่งในการหาเหตุผลทางวิทยาศาสตร์ก็คือการเสาะหาหลักฐานที่พิสูจน์ความผิดและหลักฐานที่ยืนยันความถูกต้องของสมมติฐาน[126] แต่ถึงกระนั้น ก็ยังมีเหตุการณ์หลายเหตุการณ์ในประวัติวิทยาศาสตร์ ที่นักวิทยาศาสตร์ต่อต้านการค้นพบใหม่ ๆ โดยตีความหมายแบบเลือกและไม่สนใจในข้อมูลที่คัดค้านความคิดที่มีอยู่ก่อน[126] งานวิจัยได้พบว่า งานประเมินคุณภาพของงานวิจัยวิทยาศาสตร์มีจุดอ่อนโดยเฉพาะต่อความเอนเอียงเพื่อยืนยัน คือ ได้พบว่า มีหลายครั้งหลายคราวที่นักวิทยาศาสตร์ให้คะแนนกับงานวิจัยที่พบผลที่เข้ากับความเชื่อฝ่ายตนดีกว่างานวิจัยที่พบผลที่ไม่เข้ากัน[77][127][128] อย่างไรก็ดี ถ้าสมมุติว่า คำถามที่ต้องการจะหาคำตอบนั้นมีความสำคัญ การออกแบบการทดลองก็ใช้ได้ และข้อมูลที่ได้มีการพรรณนาไว้อย่างชัดเจนและสมบูรณ์ ผลงานนั้นก็ควรจะมีความสำคัญกับวงการวิทยาศาสตร์และไม่ควรจะเกิดการพิจารณาตัดสินโดยไม่ใช้หลักฐานอย่างเป็นกลาง ๆ ไม่ว่าผลจะเข้ากันกับพยากรณ์ของทฤษฎีปัจจุบันหรือไม่[128]

ในวงการวิจัยวิทยาศาสตร์ ความเอนเอียงเพื่อยืนยันสามารถผดุงชีวิตของทฤษฎีหรือโปรแกรมงานวิจัยไว้ แม้ว่าจะมีเหตุผลที่ไม่พอเพียง หรือแม้แต่มีเหตุผลที่คัดค้าน[71][129] โดยเฉพาะอย่างยิ่ง สาขาปรจิตวิทยา (parapsychology) ได้รับอิทธิพลจากความเอนเอียงนี้เป็นอย่างยิ่ง[130]

ความเอนเอียงเพื่อยืนยันในนักวิจัยสามารถมีผลต่อข้อมูลหลักฐานที่รับการรายงาน ข้อมูลที่ไม่เข้ากับความคาดหวังของนักวิจัยอาจจะมีการทิ้งไปโดยอ้างว่า เชื่อถือไม่ได้ ซึ่งนำไปสู่ความเอนเอียงที่เรียกว่า ความเอนเอียงในการตีพิมพ์ เพื่อที่จะต่อต้านความโน้มน้าวเช่นนี้ การฝึกหัดนักวิทยาศาสตร์ต้องสอนวิธีป้องกันความเอนเอียง[131] ยกตัวอย่างเช่น งานทดลองควรจะเป็นการทดลองแบบมีกลุ่มควบคุมและเลือกผู้รับการทดลองแบบสุ่ม (randomized controlled trial) และมีการปริทัศน์ของงานทั้งระบบ (systematic review) เพื่อที่จะลดความเอนเอียงต่าง ๆ ให้อยู่ในระดับที่ต่ำที่สุด[131][132] นอกจากนั้นแล้ว กระบวนการปริทัศน์ของผู้ชำนาญในสาขาเดียวกัน (peer review) เชื่อกันว่าช่วยลดความเอนเอียงในส่วนบุคคลด้วย[133] ถึงแม้ว่า กระบวนการปริทัศน์เองก็ยังอาจจะมีความเอนเอียงอะไรบางอย่างได้[128][134]

ดังนั้น ความลำเอียงเพื่อยืนยันอาจจะก่อความเสียหายให้กับกระบวนการประเมินผลที่ควรเป็นกลาง ๆ เมื่อมีผลงานทดลองที่ไม่สอดคล้องกับความคิดที่เคยมีมาก่อน เนื่องจากว่า บุคคลที่มีความเอนเอียงอาจจะมองว่า หลักฐานที่คัดค้านไม่มีน้ำหนักและไม่ให้การพิจารณาอย่างเป็นจริงเป็นจังเพื่อที่จะแก้ความคิดเห็นฝ่ายตน[127] ดังนั้น ผู้ที่ค้นพบหลักการวิทยาศาสตร์ใหม่ ๆ มักประสบแรงต่อต้านจากกลุ่มนักวิทยาศาสตร์และงานวิจัยที่แสดงผลที่ไม่สอดคล้องกับความคิดที่มีอยู่มักได้รับการปริทัศน์ที่รุนแรง[135]

ในความรู้สึกเกี่ยวกับตน[แก้]

นักสังคมจิตวิทยาได้ระบุถึงความโน้มน้าวสองอย่างที่มนุษย์สืบหาและตีความหมายข้อมูลเกี่ยวกับตนเอง คือ การยืนยันตน (Self-verification) เป็นแรงกระตุ้นที่จะยืนยันภาพพจน์ของตน และการยกตน (self-enhancement) เป็นแรงกระตุ้นที่จะหาคำชม แรงกระตุ้นทั้งสองเกิดจากความเอนเอียงเพื่อยืนยัน[136] ในงานทดลองที่ผู้ร่วมการทดลองได้รับคำวิจารณ์ที่ขัดแย้งกับภาพพจน์ของตนเอง พวกเขามักไม่ค่อยใส่ใจหรือจะระลึกคำวิจารณ์เหล่านั้นไม่ได้เมื่อเทียบกับคำชม[137][138][139] พวกเขาจะลดแรงกระทบของข้อมูลเช่นนั้นโดยกล่าวว่า เชื่อถือไม่ได้[137][140][141] งานทดลองคล้าย ๆ กันพบความชอบใจในคำชม และคนที่กล่าวคำชมมากกว่าคำวิจารณ์ (และคนวิจารณ์)[136]

หมายเหตุ[แก้]

- ↑ ผู้เชี่ยวชาญทางพันธุศาสตร์เดวิด เพอร์กินส์บัญญัติคำว่า "myside bias" เพราะความลำเอียงต่อความคิดเห็นฝ่ายของตน (my side) (Baron 2000, p. 195)

- ↑ ข้อความในบทความ -

ทัคแมน (ค.ศ. 1984) พรรณนาถึงความลำเอียงเพื่อยืนยันแบบหนึ่งใช้เพื่อสนับสนุนนโยบายที่รัฐบาลได้กระทำ

“หลังจากที่นโยบายหนึ่งได้รับการอนุมัติและเริ่มการปฏิบัติ

การกระทำที่เกิดขึ้นหลังจากนั้นจะกลายเป็นการหาเหตุผลเพื่อที่จะสนับสนุนนโยบายนั้น” (หน้า 245)

ในเรื่องนโยบายที่ยังให้สหรัฐอเมริกาเข้าร่วมสงครามเวียดนาม

และหน่วงเหนี่ยวให้กองทัพสหรัฐต้องทำการสงครามอยู่ถึง 16 ปี

แม้ว่าจะมีหลักฐานจำนวนนับไม่ได้ที่แสดงว่า ไม่ควรจะเข้าร่วมตั้งแต่เบื้องต้น

ทัคแมนเสนอว่า หลังจากที่นโยบายหนึ่งได้รับการอนุมัติและเริ่มการปฏิบัติโดยรัฐบาล

การกระทำของรัฐที่เกิดขึ้นหลังจากนั้นจะเป็นไปเพื่อหาเหตุผลที่จะสนับสนุนนโยบายนั้น

การหลอกลวงตนเองโดยความมีหัวแข็งมีบทบาทสำคัญใน (การตัดสินใจของ) รัฐบาล

เป็นการประมวลเหตุการณ์หนึ่ง ๆ โดยใช้ความคิดเห็นตายตัวที่มีอยู่เดิม ๆ โดยไม่สนใจหรือแม้แต่ปฏิเสธหลักฐานที่ขัดแย้ง เป็นการทำการตามความหวังและเป็นการขัดขวางตนเองไม่ให้กลับความคิดได้แม้มีหลักฐานความจริง ยอดตัวอย่างในเรื่องนี้ ก็คือ คำที่นักประวัติศาสตร์กล่าวไว้เกี่ยวกับพระเจ้าเฟลีเปที่ 2 แห่งสเปน ซึ่งเป็นเจ้าแผ่นดินที่มีหัวแข็งมากที่สุดพระองค์หนึ่งว่า

“ไม่มีประสบการณ์แสดงความล้มเหลวของนโยบายของพระองค์ ที่จะสั่นคลอนความเชื่อในความยอดเยี่ยมโดยธรรมชาติ (ของนโยบาย)”

ทัคแมนเสนอว่า ความโง่เขลาเป็นการหลอกตัวเองแบบหนึ่ง ที่มีลักษณะเป็น "การยืนหยัดอยู่ในรากฐานอันหนึ่ง แม้ว่าจะมีหลักฐานที่ขัดแย้งก็ตาม" (หน้า 209)

- ↑ Assimilation bias เป็นอีกคำหนึ่งที่ใช้ในการตีความหมายเข้าข้างตน (Risen & Gilovich 2007, p. 113)

- ↑ วาสันยังใช้คำว่า "verification bias" อีกด้วย (Poletiek 2001, p. 73) ซึ่งในปัจจุบันใช้ในอีกความหมายหนึ่ง ดู Begg CB, Greenes RA (1983). "Assessment of diagnostic tests when disease verification is subject to selection bias". Biometrics. 39 (1): 207–215. doi:10.2307/2530820. PMID 6871349.

เชิงอรรถ[แก้]

อ้างอิง[แก้]

- ↑ "ศัพท์บัญญัติอังกฤษ-ไทย, ไทย-อังกฤษ ฉบับราชบัณฑิตยสถาน (คอมพิวเตอร์) รุ่น ๑.๑", ให้ความหมายของ bias ว่า "ความลำเอียง, -เอนเอียง"

- ↑ 2.0 2.1 Plous 1993, p. 233

- ↑ Darley, John M.; Gross, Paget H. (2000), "A Hypothesis-Confirming Bias in Labelling Effects", ใน Stangor, Charles (บ.ก.), Stereotypes and prejudice: essential readings, Psychology Press, p. 212, ISBN 978-0-86377-589-5, OCLC 42823720

- ↑ Risen & Gilovich 2007

- ↑ Nickerson 1998, pp. 177–178

- ↑ 6.0 6.1 6.2 6.3 Kunda 1999, pp. 112–115

- ↑ 7.0 7.1 Baron 2000, pp. 162–164

- ↑ Kida 2006, pp. 162–165

- ↑ Devine, Patricia G.; Hirt, Edward R.; Gehrke, Elizabeth M. (1990), "Diagnostic and confirmation strategies in trait hypothesis testing", Journal of Personality and Social Psychology, American Psychological Association, 58 (6): 952–963, doi:10.1037/0022-3514.58.6.952, ISSN 1939-1315

- ↑ Trope, Yaacov; Bassok, Miriam (1982), "Confirmatory and diagnosing strategies in social information gathering", Journal of Personality and Social Psychology, American Psychological Association, 43 (1): 22–34, doi:10.1037/0022-3514.43.1.22, ISSN 1939-1315

- ↑ 11.0 11.1 11.2 Klayman, Joshua; Ha, Young-Won (1987), "Confirmation, Disconfirmation and Information in Hypothesis Testing" (PDF), Psychological Review, American Psychological Association, 94 (2): 211–228, doi:10.1037/0033-295X.94.2.211, ISSN 0033-295X, สืบค้นเมื่อ 2009-08-14

- ↑ 12.0 12.1 12.2 Oswald & Grosjean 2004, pp. 82–83

- ↑ Kunda, Ziva; Fong, G.T.; Sanitoso, R.; Reber, E. (1993), "Directional questions direct self-conceptions", Journal of Experimental Social Psychology, Society of Experimental Social Psychology, 29: 62–63, ISSN 0022-1031 via Fine 2006, pp. 63–65

- ↑ 14.0 14.1 Shafir, E. (1993), "Choosing versus rejecting: why some options are both better and worse than others", Memory and Cognition, 21 (4): 546–556, PMID 8350746 via Fine 2006, pp. 63–65

- ↑ Snyder, Mark; Swann, Jr., William B. (1978), "Hypothesis-Testing Processes in Social Interaction", Journal of Personality and Social Psychology, American Psychological Association, 36 (11): 120ฃ2–1212, doi:10.1037/0022-3514.36.11.1202 via Poletiek 2001, p. 131

- ↑ 16.0 16.1 Kunda 1999, pp. 117–118

- ↑ 17.0 17.1 Albarracin, D.; Mitchell, A.L. (2004). "The Role of Defensive Confidence in Preference for Proattitudinal Information: How Believing That One Is Strong Can Sometimes Be a Defensive Weakness". Personality and Social Psychology Bulletin. 30 (12): 1565–1584. doi:10.1177/0146167204271180.

- ↑ Fischer, P.; Fischer, Julia K.; Aydin, Nilüfer; Frey, Dieter (2010). "Physically Attractive Social Information Sources Lead to Increased Selective Exposure to Information". Basic and Applied Social Psychology. 32 (4): 340–347. doi:10.1080/01973533.2010.519208.

- ↑ 19.0 19.1 19.2 Stanovich, K. E.; West, R. F.; Toplak, M. E. (2013). "Myside Bias, Rational Thinking, and Intelligence". Current Directions in Psychological Science. 22 (4): 259–264. doi:10.1177/0963721413480174.

- ↑ 20.0 20.1 Mynatt, Clifford R.; Doherty, Michael E.; Tweney, Ryan D. (1978), "Consequences of confirmation and disconfirmation in a simulated research environment", Quarterly Journal of Experimental Psychology, 30 (3): 395–406, doi:10.1080/00335557843000007

- ↑ Kida 2006, p. 157

- ↑ 22.0 22.1 22.2 22.3 22.4 22.5 Lord, Charles G.; Ross, Lee; Lepper, Mark R. (1979), "Biased assimilation and attitude polarization: The effects of prior theories on subsequently considered evidence", Journal of Personality and Social Psychology, American Psychological Association, 37 (11): 2098–2109, doi:10.1037/0022-3514.37.11.2098, ISSN 0022-3514

- ↑ 23.0 23.1 Baron 2000, pp. 201–202

- ↑ Vyse 1997, p. 122

- ↑ 25.0 25.1 25.2 25.3 Taber, Charles S.; Lodge, Milton (July 2006), "Motivated Skepticism in the Evaluation of Political Beliefs", American Journal of Political Science, Midwest Political Science Association, 50 (3): 755–769, doi:10.1111/j.1540-5907.2006.00214.x, ISSN 0092-5853

- ↑ 26.0 26.1 Westen, Drew; Blagov, Pavel S.; Harenski, Keith; Kilts, Clint; Hamann, Stephan (2006), "Neural Bases of Motivated Reasoning: An fMRI Study of Emotional Constraints on Partisan Political Judgment in the 2004 U.S. Presidential Election" (PDF), Journal of Cognitive Neuroscience, Massachusetts Institute of Technology, 18 (11): 1947–1958, doi:10.1162/jocn.2006.18.11.1947, PMID 17069484, คลังข้อมูลเก่าเก็บจากแหล่งเดิม (PDF)เมื่อ 2012-03-24, สืบค้นเมื่อ 2009-08-14

- ↑ Gadenne, V.; Oswald, M. (1986), "Entstehung und Veränderung von Bestätigungstendenzen beim Testen von Hypothesen [Formation and alteration of confirmatory tendencies during the testing of hypotheses]", Zeitschrift für experimentelle und angewandte Psychologie, 33: 360–374 via Oswald & Grosjean 2004, p. 89

- ↑ Hastie, Reid; Park, Bernadette (2005), "The Relationship Between Memory and Judgment Depends on Whether the Judgment Task is Memory-Based or On-Line", ใน Hamilton, David L. (บ.ก.), Social cognition: key readings, New York: Psychology Press, p. 394, ISBN 0-86377-591-8, OCLC 55078722

- ↑ 29.0 29.1 29.2 Oswald & Grosjean 2004, pp. 88–89

- ↑ Stangor, Charles; McMillan, David (1992), "Memory for expectancy-congruent and expectancy-incongruent information: A review of the social and social developmental literatures", Psychological Bulletin, American Psychological Association, 111 (1): 42–61, doi:10.1037/0033-2909.111.1.42

- ↑ 31.0 31.1 Snyder, M.; Cantor, N. (1979), "Testing hypotheses about other people: the use of historical knowledge", Journal of Experimental Social Psychology, 15 (4): 330–342, doi:10.1016/0022-1031(79)90042-8 via Goldacre 2008, p. 231

- ↑ Kunda 1999, pp. 225–232

- ↑ Sanitioso, Rasyid; Kunda, Ziva; Fong, G.T. (1990), "Motivated recruitment of autobiographical memories", Journal of Personality and Social Psychology, American Psychological Association, 59 (2): 229–241, doi:10.1037/0022-3514.59.2.229, ISSN 0022-3514, PMID 2213492

- ↑ 34.0 34.1 34.2 34.3 Levine, L.; Prohaska, V.; Burgess, S.L.; Rice, J.A.; Laulhere, T.M. (2001). "Remembering past emotions: The role of current appraisals". Cognition and Emotion. 15: 393–417. doi:10.1080/02699930125955.

- ↑ Safer, M.A.; Bonanno, G.A.; Field, N. (2001). ""It was never that bad": Biased recall of grief and long-term adjustment to the death of a spouse". Memory. 9 (3): 195–203. doi:10.1080/09658210143000065.

- ↑ 36.0 36.1 Russell, Dan; Jones, Warren H. (1980), "When superstition fails: Reactions to disconfirmation of paranormal beliefs", Personality and Social Psychology Bulletin, Society for Personality and Social Psychology, 6 (1): 83–88, doi:10.1177/014616728061012, ISSN 1552-7433 via Vyse 1997, p. 121

- ↑ 37.0 37.1 37.2 Kuhn, Deanna; Lao, Joseph (March 1996), "Effects of Evidence on Attitudes: Is Polarization the Norm?", Psychological Science, American Psychological Society, 7 (2): 115–120, doi:10.1111/j.1467-9280.1996.tb00340.x

- ↑ Baron 2000, p. 201

- ↑ Miller, A.G.; McHoskey, J.W.; Bane, C.M.; Dowd, T.G. (1993), "The attitude polarization phenomenon: Role of response measure, attitude extremity, and behavioral consequences of reported attitude change", Journal of Personality and Social Psychology, 64 (4): 561–574, doi:10.1037/0022-3514.64.4.561

- ↑ "backfire effect". The Skeptic's Dictionary. สืบค้นเมื่อ 26 April 2012.

- ↑ Silverman, Craig (2011-06-17). "The Backfire Effect". Columbia Journalism Review. สืบค้นเมื่อ 2012-05-01.

When your deepest convictions are challenged by contradictory evidence, your beliefs get stronger.

- ↑ 42.0 42.1 42.2 42.3 Ross, Lee; Anderson, Craig A. (1982), "Shortcomings in the attribution process: On the origins and maintenance of erroneous social assessments", ใน Kahneman, Daniel; Slovic, Paul; Tversky, Amos (บ.ก.), Judgment under uncertainty: Heuristics and biases, Cambridge University Press, pp. 129–152, ISBN 978-0-521-28414-1, OCLC 7578020

- ↑ 43.0 43.1 43.2 43.3 Nickerson 1998, p. 187

- ↑ Kunda 1999, p. 99

- ↑ Ross, Lee; Lepper, Mark R.; Hubbard, Michael (1975), "Perseverance in self-perception and social perception: Biased attributional processes in the debriefing paradigm", Journal of Personality and Social Psychology, American Psychological Association, 32 (5): 880–892, doi:10.1037/0022-3514.32.5.880, ISSN 0022-3514, PMID 1185517 via Kunda 1999, p. 99

- ↑ 47.0 47.1 47.2 47.3 47.4 Baron 2000, pp. 197–200

- ↑ 48.0 48.1 48.2 Fine 2006, pp. 66–70

- ↑ 49.0 49.1 Plous 1993, pp. 164–166

- ↑ Redelmeir, D. A.; Tversky, Amos (1996), "On the belief that arthritis pain is related to the weather", Proceedings of the National Academy of Sciences, 93 (7): 2895–2896, doi:10.1073/pnas.93.7.2895 via Kunda 1999, p. 127

- ↑ 51.0 51.1 51.2 Kunda 1999, pp. 127–130

- ↑ Plous 1993, pp. 162–164

- ↑ ดัดแปลงจาก Fielder, Klaus (2004), "Illusory correlation", ใน Pohl, Rüdiger F. (บ.ก.), Cognitive Illusions: A Handbook on Fallacies and Biases in Thinking, Judgement and Memory, Hove, UK: Psychology Press, p. 103, ISBN 978-1-84169-351-4, OCLC 55124398

- ↑ Stanovich, K. E.; West, R. F.; Toplak, M. E. (5 August 2013). "Myside Bias, Rational Thinking, and Intelligence". Current Directions in Psychological Science. 22 (4): 259–264. doi:10.1177/0963721413480174.

- ↑ Baron, Jonathan (1995). "Myside bias in thinking about abortion". Thinking & Reasoning: 221–235.

- ↑ 56.0 56.1 56.2 Wolfe, Christopher; Anne Britt (2008). "The locus of the myside bias in written argumentation". Thinking & Reasoning: 1–27.

- ↑ Mason, Lucia; Scirica, Fabio (October 2006). "Prediction of students' argumentation skills about controversial topics by epistemological understanding". Learning and Instruction. 16 (5): 492–509. doi:10.1016/j.learninstruc.2006.09.007.

- ↑ Weinstock, Michael (December 2009). "Relative expertise in an everyday reasoning task: Epistemic understanding, problem representation, and reasoning competence". Learning and Individual Differences. 19 (4): 423–434. doi:10.1016/j.lindif.2009.03.003.

- ↑ Weinstock, Michael; Neuman, Yair; Tabak, Iris (January 2004). "Missing the point or missing the norms? Epistemological norms as predictors of students' ability to identify fallacious arguments". Contemporary Educational Psychology. 29 (1): 77–94. doi:10.1016/S0361-476X(03)00024-9.

- ↑ 60.0 60.1 Baron 2000, pp. 195–196

- ↑ Thucydides 4.108.4

- ↑ Alighieri, Dante. Paradiso canto XIII: 118–120. Trans. Allen Mandelbaum

- ↑ 63.0 63.1 Bacon, Francis (1620) . Novum Organum. reprinted in Burtt, E.A., บ.ก. (1939), The English philosophers from Bacon to Mill, New York: Random House, p. 36 via Nickerson 1998, p. 176

- ↑ Tolstoy, Leo. What is Art? p. 124 (1899) . ในงานชิ้นโบแดงของตอลสตอย The Kingdom of God Is Within You (ราชอาณาจักรของพระเจ้าอยู่ในตัวคุณ) (ค.ศ. 1893) เขาได้กล่าวคำที่คล้ายกันไว้ว่า "เรื่องที่ยากที่สุดสามารถอธิบายให้คนที่มีสติปัญญาช้าที่สุด ถ้าเขายังไม่มีความเห็นในเรื่องนั้น แต่เรื่องที่ง่ายที่สุดกลับไม่สามารถทำให้ชัดเจนแก่คนที่ฉลาดที่สุด ถ้าเขาเชื่อว่าเขารู้แล้ว โดยไร้เงาของความสงสัย ว่าอะไรเป็นอะไร" (บทที่ 3) แปลจากภาษารัสเซียโดยคอนแสต็นซ์ การ์เน็ตต์ มหานครนิวยอร์ก ค.ศ. 1894 Project Gutenberg edition เรียกดูเมื่อ 2009-08-24.

- ↑ Gale, Maggie; Ball, Linden J. (2002), "Does Positivity Bias Explain Patterns of Performance on Wason's 2-4-6 task?", ใน Gray, Wayne D.; Schunn, Christian D. (บ.ก.), Proceedings of the Twenty-Fourth Annual Conference of the Cognitive Science Society, Routledge, p. 340, ISBN 978-0-8058-4581-5, OCLC 469971634

- ↑ 66.0 66.1 Wason, Peter C. (1960), "On the failure to eliminate hypotheses in a conceptual task", Quarterly Journal of Experimental Psychology, Psychology Press, 12 (3): 129–140, doi:10.1080/17470216008416717, ISSN 1747-0226

- ↑ Nickerson 1998, p. 179

- ↑ Lewicka 1998, p. 238

- ↑ Oswald & Grosjean 2004, pp. 79–96

- ↑ Wason, Peter C. (1968), "Reasoning about a rule", Quarterly Journal of Experimental Psychology, Psychology Press, 20 (3): 273–28, doi:10.1080/14640746808400161, ISSN 1747-0226

- ↑ 71.0 71.1 71.2 Sutherland, Stuart (2007), Irrationality (2nd ed.), London: Pinter and Martin, pp. 95–103, ISBN 978-1-905177-07-3, OCLC 72151566

- ↑ Barkow, Jerome H.; Cosmides, Leda; Tooby, John (1995), The adapted mind: evolutionary psychology and the generation of culture, Oxford University Press US, pp. 181–184, ISBN 978-0-19-510107-2, OCLC 33832963

- ↑ Oswald & Grosjean 2004, pp. 81–82, 86–87

- ↑ Lewicka 1998, p. 239

- ↑ Tweney, Ryan D.; Doherty, Michael E.; Worner, Winifred J.; Pliske, Daniel B.; Mynatt, Clifford R.; Gross, Kimberly A.; Arkkelin, Daniel L. (1980), "Strategies of rule discovery in an inference task", The Quarterly Journal of Experimental Psychology, Psychology Press, 32 (1): 109–123, doi:10.1080/00335558008248237, ISSN 1747-0226 (Experiment IV)

- ↑ Oswald & Grosjean 2004, pp. 86–89

- ↑ 77.0 77.1 Hergovich, Schott & Burger 2010

- ↑ Maccoun 1998

- ↑ Friedrich 1993, p. 298

- ↑ Kunda 1999, p. 94

- ↑ Nickerson 1998, pp. 198–199

- ↑ Nickerson 1998, p. 200

- ↑ 83.0 83.1 83.2 Nickerson 1998, p. 197

- ↑ Baron 2000, p. 206

- ↑ Matlin, Margaret W. (2004), "Pollyanna Principle", ใน Pohl, Rüdiger F. (บ.ก.), Cognitive Illusions: A Handbook on Fallacies and Biases in Thinking, Judgement and Memory, Hove: Psychology Press, pp. 255–272, ISBN 978-1-84169-351-4, OCLC 55124398

- ↑ Dawson, Erica; Gilovich, Thomas; Regan, Dennis T. (October 2002), "Motivated Reasoning and Performance on the Wason Selection Task" (PDF), Personality and Social Psychology Bulletin, Society for Personality and Social Psychology, 28 (10): 1379–1387, doi:10.1177/014616702236869, สืบค้นเมื่อ 2009-09-30

- ↑ Ditto, Peter H.; Lopez, David F. (1992), "Motivated skepticism: use of differential decision criteria for preferred and nonpreferred conclusions", Journal of personality and social psychology, American Psychological Association, 63 (4): 568–584, doi:10.1037/0022-3514.63.4.568, ISSN 0022-3514

- ↑ Nickerson 1998, p. 198

- ↑ Oswald & Grosjean 2004, pp. 91–93

- ↑ Friedrich 1993, pp. 299, 316–317

- ↑ Trope, Y.; Liberman, A. (1996), "Social hypothesis testing: cognitive and motivational mechanisms", ใน Higgins, E. Tory; Kruglanski, Arie W. (บ.ก.), Social Psychology: Handbook of basic principles, New York: Guilford Press, ISBN 978-1-57230-100-9, OCLC 34731629 via Oswald & Grosjean 2004, pp. 91–93

- ↑ 92.0 92.1 Dardenne, Benoit; Leyens, Jacques-Philippe (1995), "Confirmation Bias as a Social Skill", Personality and Social Psychology Bulletin, Society for Personality and Social Psychology, 21 (11): 1229–1239, doi:10.1177/01461672952111011, ISSN 1552-7433

- ↑ Shanteau, James (2003). Sandra L. Schneider (บ.ก.). Emerging perspectives on judgment and decision research. Cambridge [u.a.]: Cambridge University Press. p. 445. ISBN 0-521-52718-X.

- ↑ Haidt, Jonathan (2012). The Righteous Mind : Why Good People are Divided by Politics and Religion. New York: Pantheon Books. pp. 1473–4 (e-book edition). ISBN 0-307-37790-3.

- ↑ Fiske, Susan T.; Gilbert, Daniel T.; Lindzey, Gardner, บ.ก. (2010), The handbook of social psychology (5th ed.), Hoboken, NJ: Wiley, p. 811, ISBN 978-0470137499

- ↑ 96.0 96.1 Zweig, Jason (November 19, 2009), "How to Ignore the Yes-Man in Your Head", Wall Street Journal, Dow Jones & Company, สืบค้นเมื่อ 2010-06-13

- ↑ Pompian, Michael M. (2006), Behavioral finance and wealth management: how to build optimal portfolios that account for investor biases, John Wiley and Sons, pp. 187–190, ISBN 978-0-471-74517-4, OCLC 61864118

- ↑ Hilton, Denis J. (2001), "The psychology of financial decision-making: Applications to trading, dealing, and investment analysis", Journal of Behavioral Finance, Institute of Behavioral Finance, 2 (1): 37–39, doi:10.1207/S15327760JPFM0201_4, ISSN 1542-7579

- ↑ Krueger, David; Mann, John David (2009), The Secret Language of Money: How to Make Smarter Financial Decisions and Live a Richer Life, McGraw Hill Professional, pp. 112–113, ISBN 978-0-07-162339-1, OCLC 277205993

- ↑ 100.0 100.1 Nickerson 1998, p. 192

- ↑ Goldacre 2008, p. 233

- ↑ Singh, Simon; Ernst, Edzard (2008), Trick or Treatment?: Alternative Medicine on Trial, London: Bantam, pp. 287–288, ISBN 978-0-593-06129-9

- ↑ Atwood, Kimball (2004), "Naturopathy, Pseudoscience, and Medicine: Myths and Fallacies vs Truth", Medscape General Medicine, 6 (1): 33

- ↑ Neenan, Michael; Dryden, Windy (2004), Cognitive therapy: 100 key points and techniques, Psychology Press, p. ix, ISBN 978-1-58391-858-6, OCLC 474568621

- ↑ Blackburn, Ivy-Marie; Davidson, Kate M. (1995), Cognitive therapy for depression & anxiety: a practitioner's guide (2 ed.), Wiley-Blackwell, p. 19, ISBN 978-0-632-03986-9, OCLC 32699443

- ↑ Harvey, Allison G.; Watkins, Edward; Mansell, Warren (2004), Cognitive behavioural processes across psychological disorders: a transdiagnostic approach to research and treatment, Oxford University Press, pp. 172–173, 176, ISBN 978-0-19-852888-3, OCLC 602015097

- ↑ Nickerson 1998, pp. 191–193

- ↑ Myers, D.G.; Lamm, H. (1976), "The group polarization phenomenon", Psychological Bulletin, 83 (4): 602–627, doi:10.1037/0033-2909.83.4.602 via Nickerson 1998, pp. 193–194

- ↑ Halpern, Diane F. (1987), Critical thinking across the curriculum: a brief edition of thought and knowledge, Lawrence Erlbaum Associates, p. 194, ISBN 978-0-8058-2731-6, OCLC 37180929

- ↑ Roach, Kent (2010), "Wrongful Convictions: Adversarial and Inquisitorial Themes", North Carolina Journal of International Law and Commercial Regulation, 35, SSRN 1619124,

Both adversarial and inquisitorial systems seem subject to the dangers of tunnel vision or confirmation bias.

- ↑ Baron 2000, pp. 191, 195

- ↑ Kida 2006, p. 155

- ↑ Tetlock, Philip E. (2005), Expert Political Judgment: How Good Is It? How Can We Know?, Princeton, N.J.: Princeton University Press, pp. 125–128, ISBN 978-0-691-12302-8, OCLC 56825108

- ↑ "David Camm Blog: Investigation under fire". WDRB. October 10, 2013.

- ↑ Kircher, Travis. "David Camm blogsite: opening statements". WDRB. สืบค้นเมื่อ January 3, 2014.

- ↑ "David Camm v. State of Indiana" (PDF). Court of Appeals of Indiana. 2011-11-15.

- ↑ Boyd, Gordon (September 10, 2013). "Camm trial 9/10: Defense finds inconsistencies but can't touch Boney's past". WBRC.

- ↑ Zambroski,James. "Witness Says Prosecutor In First Camm Trial Blew Up When She Couldn't Link Camm's DNA To Boney's Shirt". WAVE News. คลังข้อมูลเก่าเก็บจากแหล่งเดิมเมื่อ 2017-04-01. สืบค้นเมื่อ 2014-07-02.

- ↑ Eisenmenger, Sarah (September 9, 2013). "Convicted Killer Charles Boney says David Camm was the shooter". wave3. สืบค้นเมื่อ January 5, 2014.

- ↑ Eisenmenger, Sarah (Sep 9, 2013). "Convicted Killer Charles Boney says David Camm was the shooter". wave3.

- ↑ Adams, Harold J. (2011-02-18). "David Camm's attorney's appeal ruling, seek prosecutor's removal". Courier Journal, page B1.

- ↑ David Camm verdict: NOT GUILTY, WDRB TV, October 24, 2013

- ↑ 123.0 123.1 Smith, Jonathan C. (2009), Pseudoscience and Extraordinary Claims of the Paranormal: A Critical Thinker's Toolkit, John Wiley and Sons, pp. 149–151, ISBN 978-1-4051-8122-8, OCLC 319499491

- ↑ Randi, James (1991), James Randi: psychic investigator, Boxtree, pp. 58–62, ISBN 978-1-85283-144-8, OCLC 26359284

- ↑ 125.0 125.1 Nickerson 1998, p. 190

- ↑ 126.0 126.1 Nickerson 1998, pp. 192–194

- ↑ 127.0 127.1 Koehler 1993

- ↑ 128.0 128.1 128.2 Mahoney 1977

- ↑ Proctor, Robert W.; Capaldi, E. John (2006), Why science matters: understanding the methods of psychological research, Wiley-Blackwell, p. 68, ISBN 978-1-4051-3049-3, OCLC 318365881

- ↑ Sternberg, Robert J. (2007), "Critical Thinking in Psychology: It really is critical", ใน Sternberg, Robert J.; Roediger III, Henry L.; Halpern, Diane F. (บ.ก.), Critical Thinking in Psychology, Cambridge University Press, p. 292, ISBN 0-521-60834-1, OCLC 69423179,

ตัวอย่างที่เสียหายที่สุดของความเอนเอียงเพื่อยืนยันเป็นงานวิจัยทาง parapsychology โดยเหตุผลแล้ว นี่เป็นสาขาการศึกษาที่ไม่มีข้อมูลสนับสนุนที่มีกำลังโดยประการทั้งปวง แต่เพราะว่ามีคนต้องการจะเชื่อ ดังนั้นจึงหาวิธีที่จะเชื่อ

- ↑ 131.0 131.1 Shadish, William R. (2007), "Critical Thinking in Quasi-Experimentation", ใน Sternberg, Robert J.; Roediger III, Henry L.; Halpern, Diane F. (บ.ก.), Critical Thinking in Psychology, Cambridge University Press, p. 49, ISBN 978-0-521-60834-3

- ↑ PMID 11440947 (PMID 11440947)

Citation will be completed automatically in a few minutes. Jump the queue or expand by hand - ↑ Shermer, Michael (July 2006), "The Political Brain", Scientific American, ISSN 0036-8733, สืบค้นเมื่อ 2009-08-14

- ↑ PMID 21098355 (PMID 21098355)

Citation will be completed automatically in a few minutes. Jump the queue or expand by hand - ↑ Horrobin 1990

- ↑ 136.0 136.1 Swann, William B.; Pelham, Brett W.; Krull, Douglas S. (1989), "Agreeable fancy or disagreeable truth? Reconciling self-enhancement and self-verification", Journal of Personality and Social Psychology, 57 (5): 782–is 791, doi:10.1037/0022-3514.57.5.782, ISSN 0022-3514, PMID 2810025

- ↑ 137.0 137.1 Swann, William B.; Read, Stephen J. (1981), "Self-verification processes: How we sustain our self-conceptions", Journal of Experimental Social Psychology, 17 (4): 351–372, doi:10.1016/0022-1031(81)90043-3, ISSN 0022-1031

- ↑ Story, Amber L. (1998), "Self-Esteem and Memory for Favorable and Unfavorable Personality Feedback", Personality and Social Psychology Bulletin, Society for Personality and Social Psychology, 24 (1): 51–64, doi:10.1177/0146167298241004, ISSN 1552-7433

- ↑ White, Michael J.; Brockett, Daniel R.; Overstreet, Belinda G. (1993), "Confirmatory Bias in Evaluating Personality Test Information: Am I Really That Kind of Person?", Journal of Counseling Psychology, American Psychological Association, 40 (1): 120–126, doi:10.1037/0022-0167.40.1.120, ISSN 0022-0167

- ↑ Swann, William B.; Read, Stephen J. (1981), "Acquiring self-knowledge: The search for feedback that fits", Journal of Personality and Social Psychology, 41 (6): 1119–1328, CiteSeerX 10.1.1.537.2324, doi:10.1037/0022-3514.41.6.1119, ISSN 0022-3514

- ↑ Shrauger, J. Sidney; Lund, Adrian K. (1975), "Self-evaluation and reactions to evaluations from others", Journal of Personality, Duke University Press, 43 (1): 94–108, doi:10.1111/j.1467-6494.1975.tb00574, PMID 1142062

แหล่งที่มา[แก้]

- Baron, Jonathan (2000), Thinking and deciding (3rd ed.), New York: Cambridge University Press, ISBN 978-0521650304, OCLC 316403966

- Fine, Cordelia (2006), A Mind of its Own: how your brain distorts and deceives, Cambridge, UK: Icon Books, ISBN 978-1840466782, OCLC 60668289

- Friedrich, James (1993), "Primary error detection and minimization (PEDMIN) strategies in social cognition: a reinterpretation of confirmation bias phenomena", Psychological Review, 100 (2): 298–319, doi:10.1037/0033-295X.100.2.298, ISSN 0033-295X, PMID 8483985

- Goldacre, Ben (2008), Bad science, London: Fourth Estate, ISBN 978-0007240197, OCLC 259713114

- Hergovich, Andreas; Schott, Reinhard; Burger, Christoph (2010), "Biased evaluation of abstracts depending on topic and conclusion: Further evidence of a confirmation bias within scientific psychology", Current Psychology, 29 (3): 188–209, doi:10.1007/s12144-010-9087-5, S2CID 145497196

- Kida, Thomas E. (2006), Don't believe everything you think: The 6 basic mistakes we make in thinking, Amherst, NY: Prometheus Books, ISBN 978-1591024088, OCLC 63297791

- Koehler, Jonathan J. (1993), "The influence of prior beliefs on scientific judgments of evidence quality", Organizational Behavior and Human Decision Processes, 56: 28–55, doi:10.1006/obhd.1993.1044

- Kunda, Ziva (1999), Social cognition: Making sense of people, MIT Press, ISBN 978-0262611435, OCLC 40618974

- Lewicka, Maria (1998), "Confirmation bias: Cognitive error or adaptive strategy of action control?", ใน Kofta, Mirosław; Weary, Gifford; Sedek, Grzegorz (บ.ก.), Personal control in action: Cognitive and motivational mechanisms, Springer, pp. 233–255, ISBN 978-0306457203, OCLC 39002877

- MacCoun, Robert J. (1998), "Biases in the interpretation and use of research results" (PDF), Annual Review of Psychology, 49: 259–287, doi:10.1146/annurev.psych.49.1.259, PMID 15012470

- Mahoney, Michael J. (1977), "Publication prejudices: An experimental study of confirmatory bias in the peer review system", Cognitive Therapy and Research, 1 (2): 161–175, doi:10.1007/BF01173636, S2CID 7350256

- Nickerson, Raymond S. (1998), "Confirmation bias: A ubiquitous phenomenon in many guises", Review of General Psychology, 2 (2): 175–220, doi:10.1037/1089-2680.2.2.175, S2CID 8508954

- Oswald, Margit E.; Grosjean, Stefan (2004), "Confirmation bias", ใน Pohl, Rüdiger F. (บ.ก.), Cognitive illusions: A handbook on fallacies and biases in thinking, judgement and memory, Hove, UK: Psychology Press, pp. 79–96, ISBN 978-1841693514, OCLC 55124398

- Plous, Scott (1993), The psychology of judgment and decision making, McGraw-Hill, ISBN 978-0070504776, OCLC 26931106

- Poletiek, Fenna (2001), Hypothesis-testing behaviour, Hove, UK: Psychology Press, ISBN 978-1841691596, OCLC 44683470

- Risen, Jane; Gilovich, Thomas (2007), "Informal logical fallacies", ใน Sternberg, Robert J.; Roediger III, Henry L.; Halpern, Diane F. (บ.ก.), Critical thinking in psychology, Cambridge University Press, pp. 110–130, ISBN 978-0521608343, OCLC 69423179

- Vyse, Stuart A. (1997), Believing in magic: The psychology of superstition, New York: Oxford University Press, ISBN 978-0195136340, OCLC 35025826

- Wason, Peter C. (1960), "On the failure to eliminate hypotheses in a conceptual task", Quarterly Journal of Experimental Psychology, 12 (3): 129–140, doi:10.1080/17470216008416717, ISSN 1747-0226, S2CID 19237642

อ่านเพิ่ม[แก้]

- Keohane, Joe (11 July 2010), "How facts backfire: Researchers discover a surprising threat to democracy: our brains", Boston Globe, The New York Times

- Leavitt, Fred (2015), Dancing with absurdity: Your most cherished beliefs (and all your others) are probably wrong, Peter Lang Publishers

- Stanovich, Keith (2009), What intelligence tests miss: The psychology of rational thought (Lay), New Haven (CT): Yale University Press, ISBN 978-0300123852

- Westen, Drew (2007), The political brain: The role of emotion in deciding the fate of the nation, PublicAffairs, ISBN 978-1586484255, OCLC 86117725

แหล่งข้อมูลอื่น[แก้]

- Skeptic's Dictionary: confirmation bias – Robert T. Carroll

- Teaching about confirmation bias – class handout and instructor's notes by K.H. Grobman

- Confirmation bias at You Are Not So Smart

- Confirmation bias learning object – interactive number triples exercise by Rod McFarland for Simon Fraser University

- Brief summary of the 1979 Stanford assimilation bias study – Keith Rollag, Babson College